Wie klassische KI-Systeme intelligenter werden

Vom maschinellen Sehen zur maschinellen Wahrnehmung

Prof. Dr. Ralf Otte, Prof. Dr. Viktor Otte

Wie könnte die Bildverarbeitung der Zukunft aussehen? Um in den Bereichen autonomes Fahren und mobiler Robotik Fortschritte zu erreichen, muss die Bilderkennung besser werden beziehungsweise mit deutlich weniger Lerndaten auskommen als bisher. Aus Sicht der Autoren ist hierfür eine maschinelle Wahrnehmung unabdingbar. Doch worin besteht der Unterschied zwischen maschinellem Sehen und maschineller Wahrnehmung? Und wie schafft ein künstliches System einen solchen Intelligenzsprung? Eine Grundsatzdebatte.

Wenn wir in unserer Umwelt zielgerichtet agieren wollen, sind wir auf unsere Sinnesorgane angewiesen. Dazu gehören neben Sehen und Hören die taktile Wahrnehmung, Temperaturempfindungen und Schwingungen. Sollen künstliche Systeme, wie Roboter, menschliche Tätigkeiten in der natürlichen Umgebung übernehmen, so muss ihre Sensorik diesen Aufgaben angepasst werden. Das Sehen als unsere wichtigste Datenquelle, man spricht von circa 95 Prozent der Informationsaufnahme, ist daher künstlich nachzubilden. Üblich sind heute digitale Sensorsysteme, die dem Gesamtsystem in zwei Stufen visuelle Daten zur Verfügung stellen: in der ersten Stufe die digitale Abbildung (also die interne Repräsentation), in der zweiten Stufe die Rückrechnung zu geometrischen Positionen aus diesen internen Abbildungen. Ist das auch in Zukunft die gängige Methode? Oder werden sich andere Möglichkeiten ergeben, die sich dem menschlichen Wahrnehmen annähern?

Die Intelligenz-Fähigkeit der Maschine

Um die Geschwindigkeit besser verstehen zu können, mit der Maschinen intelligenter werden, ist eine einfache Klassifikation der Intelligenzstufen der maschinellen Verarbeitung hilfreich. Die 1. Stufe der Intelligenz soll als „deduktive Intelligenz“ bezeichnet werden. Wir verstehen darunter logisch adäquates Schlussfolgern auf Eingangsgrößen eines Systems. Bereits Taschenrechner erfüllen diese Forderung. Kann das System lernen, wollen wir das als 2. Stufe, oder als „induktive Intelligenz“ bezeichnen. Denken Sie an ein Kind und eine heiße Herdplatte. Das Kind wird sie vermutlich nur einmal berühren, aber eine Stubenfliege fliegt beharrlich bis zum Tod gegen die Fensterscheibe, weil ihre Intelligenz der Stufe 1 die Glasscheibe als Trennung zwischen den Räumen nicht erlernen kann. Kann das System Deduktion und Induktion jedoch sogar verbinden, so wollen wir von einer 3. Stufe, der „kognitiven Intelligenz“ und sogar Kreativität sprechen. Die heutige KI steht an dieser Schwelle. Sie kann nach einer hinreichenden Lernphase Texte generieren, Bilder zeichnen, auch neue Ideen durch Kombination erzeugen, bleibt aber dabei im gelernten Datenraum. Sie interpoliert also meistens. Außergewöhnliches Agieren erfordert aber immer auch eine Extrapolation, also die Datenverarbeitung außerhalb des Gelernten. Aber selbst das lässt sich mathematisch simulieren. Allerdings neigen viele Systeme im Extrapolationsraum zum Halluzinieren, eine euphemistische Beschreibung dafür, dass die Vorhersagen des KI-Systems völlig falsch sind.

Auf Stufe 3, der Kognition, endet der bisherige Evolutionsprozess der künstlichen, intelligenten Systeme. Für den Sprung zur Stufe 4 muss die künstliche Intelligenz über die Simulation hinausgehen. Stufe 4 wollen wir als die „Intelligenz der bewussten Wahrnehmung“ bezeichnen.

Die falsche Prognose

Wie könnte ein künstliches System diesen erneuten Intelligenzsprung durchführen? Die übliche Antwort lautet: durch Emergenz. Was bedeutet das? Emergenz bezeichnet die Möglichkeit der Herausbildung von neuen Eigenschaften oder Strukturen eines Systems infolge des Zusammenspiels seiner Elemente. Die KI-Systeme werden komplizierter und komplexer, die Selbsterzeugung neuer Eigenschaften darf also nicht a priori ausgeschlossen werden. Von wesentlicher Bedeutung bei dieser Annahme ist aber, dass die technische Struktur der KI-Systeme variabel sein müsste. Die Anzahl der Neuronen und ihrer Verbindungen in den Künstlichen Neuronalen Netzen (KNN) erhöhen sich ständig, aber die Systemstruktur ist gegenwärtig von außen, vom Konstrukteur festgelegt. Da „wächst“ nichts Neues im Computer, alle Veränderungen passieren in Software. Die kybernetische Struktur des KI-Computers verändert sich beim Lernen nicht. Das aber wäre die Voraussetzung, um aus einer vorgegebenen Struktur auszubrechen. Der strukturelle Aufbau der klassischen KI lässt das gegenwärtig nicht zu und damit ist die Hoffnung auf Emergenz vermutlich vergeblich. Anders ist es im Gehirn, bei dem sich die Wetware (Hardware) beim Lernen permanent selbst verändert. Das hat enorme Konsequenzen.

Der Unterschied zwischen Sehen und Wahrnehmen

Sehen und Wahrnehmen sind zwei völlig verschiedene physikalische Prozesse. Betrachten wir zur Erläuterung zuerst den Prozess des „Sehens“ bei technischen Systemen. Was „sieht“ also der Computer? Das Wort „Sehen“ setzt ein Verständnis am Prozess voraus, das aber können wir dem Computer nicht zubilligen. Technische Mittel, in der Regel Kameras, erzeugen ein digitales Abbild der betrachteten Umgebung. Das Bild wird mit mathematischen Verfahren der Trigonometrie ausgewertet und ein Modell der Umgebung errechnet, mit dem das System manövrieren kann. Aber nimmt der Computer das Bild beziehungsweise Modell des Gegenstandes (und damit abgeleitet den Gegenstand selbst) wahr? Nein. Wir dürfen diesen Prozess nicht mit dem Identifizieren von Objekten verwechseln, wir er bei der Bilderkennung mit neuronalen Netzen üblich ist. Die Idee von G. Hinton war seinerzeit, mit sogenannten neuronalen Faltungsnetzen Invarianz in Bildern trotz rotatorischer oder translatorischer Veränderungen zu erkennen. Eine Katze bleibt eine Katze, auch wenn sie auf dem Rücken liegt. Die Zahl der notwendigen Lehrbeispiele konnte dadurch deutlich gesenkt werden. Aber Kinder brauchen nur 3 bis 5 Katzenbilder, um Katzen für immer von umgefallenen Stühlen oder anderen Tieren zu unterscheiden. Das sind weiterhin hundertfach weniger Trainingsdaten als die beste heutige KI dafür benötigen würde. Warum ist das so? Die KI sieht nur das digitale Bild im elementaren Sinne, sie versteht es nicht. Doch das Hauptproblem ist: Die KI repräsentiert die Umgebung ausschließlich in ihrem Inneren, im Hauptspeicher des Systems. Sie errechnet daraus ihr Umfeld, nach menschlichem Verständnis ist sie daher blind, denn die KI sieht dort draußen nichts.

Menschliche Wahrnehmung als intrinsische Eigenschaft

Wie sieht der Mensch und wie nimmt er die betrachteten Gegenstände wahr? Die erste Phase des Prozesses ist der digitalen Bildverarbeitung ähnlich. Durch die Augen wird der betrachtete Gegenstand auf die Netzhautzellen abgebildet und elektrophysiologisch über Nervenbahnen an neuronale Netze im Gehirn weitergeleitet, die in verschiedenen Stufen die Informationen verarbeiten. Es gibt dabei kein Bild im Ganzen mehr. Unterschiedliche Bildinhalte, Farben und Bewegungen werden sukzessiv und einzeln behandelt. Dennoch müssen diese einzelnen Verarbeitungsschritte zu einer inneren Repräsentation des äußeren Objektes zusammengesetzt werden können. Obwohl eine derartige ganzheitliche Bildsynthese im Gehirn bisher nicht nachgewiesen werden konnte, muss ein Prozess dazu führen, dass wir trotzdem ein Gesamtbild sehen und zusätzlich – und das ist ein unerklärlicher Vorgang – das Bild nicht im Inneren des Kopfes, sondern im Außen, und zwar genau dort sehen, besser wahrnehmen, wo sich der Gegenstand tatsächlich auch befindet. Bild und Gegenstand sind also deckungsgleich. Dieser Vorgang ist bis heute völlig unverständlich und die Autoren leiten daraus eine Hypothese ab: Wir Menschen sehen nicht nur mit den Augen, sondern zwingend auch mit unserem Bewusstsein. Das „gesamte Außen“ ist im Bewusstsein präsent. Die Augen sind nur das Instrument, das für das neuronale Netz im Gehirn die Teile der Umwelt selektiert, die unser Bewusstsein dann wahrnimmt. In unserem Gehirn wird auch nicht gerechnet, wenn wir die Umgebung betrachten. Menschen repräsentieren daher nicht nur ihre Umwelt im Inneren, sondern sie sind unmittelbar in ihr. Sie nehmen die Objekte der Umgebung immer dort wahr, wo diese sich auch in der physikalischen Realität befinden. Genau das unterscheidet digitales Sehen von menschlicher Wahrnehmung. Da es keinerlei mathematische Prozesse gibt, die die internen Repräsentationen im visuellen Cortex zurück in die Umwelt projizieren könnten, muss sich hinter der Wahrnehmung im Außen ein echter physikalischer Prozess befinden. Eine KI, die ausschließlich auf mathematische Operationen setzt, wird daher niemals wahrnehmen können. Es fehlt der Mathematik sozusagen die „kausale Kraft“, die ein echter physikalischer Prozess besitzt. Wenn man in einem Computer die Schwerkraft mathematisch simuliert, so entsteht natürlich keine Schwerkraft. Wenn man in einem Computer Sehprozesse simuliert, so entsteht kein physikalischer Prozess, der die internen Abbildungen nach außen projizieren könnte. Nur ein echter physikalischer Prozess kann Wahrnehmungseffekte erzeugen.

Zugegeben, eine merkwürdige Vorstellung. Sie ist nur verständlich und für eine technische Konstruktion auch nur dann nützlich, wenn wir eine weitere Hypothese aufstellen: Wir sagen, Wahrnehmungsprozesse sind eine intrinsische, der Materie also innewohnende, physikalische Eigenschaft, grundsätzlich vorhanden (wie die Schwerkraft bei Masse). Ab einer gewissen Organisationshöhe der Struktur, also beim Tier oder Menschen, erzeugen diese Prozesse bewusste Wahrnehmungen. Und nun folgen die ungewöhnlichsten Annahmen: Diese Fähigkeiten der (Außen-)Wahrnehmung sind zwar materiell an das Gehirn gebunden, aber dort nicht lokalisiert, und – das ist eine sehr gewöhnungsbedürftige Sichtweise - selbst ohne reell-wertige Energieinhalte und deshalb durch keinerlei physikalische Instrumente messbar, obwohl physikalisch existent. Das klingt auf den ersten Blick suspekt, aber mathematische Analysen auf spezifischen hyperkomplexen Wellenfunktionen ergeben nicht-reellwertige Energieeigenwerte [1]. Wir postulieren daher, dass Wellenfunktionen, beschrieben auf Basis einer speziellen Algebra, die physikalische Grundlage für (bewusste) Wahrnehmungen sind [2], [3]. Wenn das so ist, wären Wahrnehmungsprozesse durch technische Apparate nutzbar.

Könnte man solche Wahrnehmungsprozesse beschreiben? Natürlich nicht geschlossen, aber wenigstens einen Teilaspekt? Die Autoren haben - wie oben ausgeführt - durch Operationen in einer hyperkomplexen Mathematik (ähnlich Quaternionen, jedoch bi-komplex) die Möglichkeit aufgezeigt, dass hyperkomplexe Prozesse, wie eventuell auch das bewusste Wahrnehmen, die Fähigkeit besitzen, Informationen aufzunehmen, zu speichern und wiederzugeben.

Wahrnehmen mit maschinellem Bewusstsein

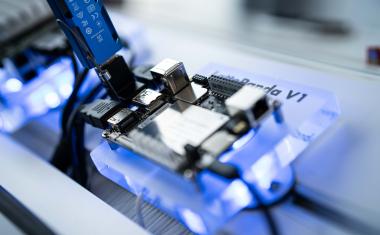

Wir haben also eine mathematische Beschreibung, aber noch keine Konstruktionsanleitung, um wahrnehmungsfähige, technische Systeme zu erzeugen. Mehr hilft uns dazu die Annahme, dass hyperkomplexe Wahrnehmungsprozesse eine intrinsische Eigenschaft organisierter Materie sind, immer vorhanden, nur nicht immer präsent. Wie kann man das Vorhandensein einer nicht-reellwertigen Eigenschaft nachweisen? Wie in der Physik, in der man zum Beispiel Felder nicht explizit, sondern über ihre Wirkungen erkennt. Wir benötigen also eine KI-Struktur mit neuronalen Netzen, die den intrinsischen Effekt der latent vorhandenen Wahrnehmungsmöglichkeit nicht ausblendet, sondern verstärkt. Grundsätzlich sind dafür alle Systemstrukturen geeignet, die nicht digitalisieren, sondern die natürliche, analoge Arbeitsweise der Natur zulassen. Dazu gehören neuromorphe Computer mit Memristoren, Quantenrechner und Licht-/Photonenrechner.

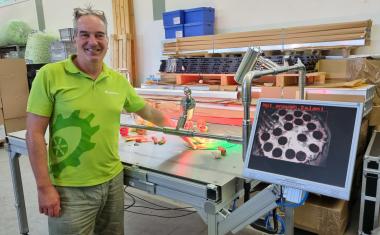

Der Test auf „Wahrnehmungsfähigkeit einer Maschine“ wäre hier ähnlich zu konzipieren, wie der Turing-Test zur maschinellen Intelligenz [3]. KI-Systeme, die nach obiger Beschreibung wahrnehmen können, müssen bei der Bilderkennung signifikant besser sein als Vergleichssysteme und mit wesentlich weniger Lerndaten auskommen. Besonders deutlich würde sich diese Eigenschaft als Überlegenheit beim autonomen Fahren und der mobilen Robotik in natürlicher Umgebung zeigen. Was ist also zu tun? Eine Kamera, die ihre Abbilder auf ein nicht digitales neuronales Netz gibt, ahmt die Wahrnehmungsprozesse des Gehirns viel besser nach als jedwede mathematische Simulation. Daher sollten in der Bildverarbeitung langfristig neuromorphe Systeme zum Einsatz kommen, um echte Wahrnehmungsprozesse des Nach-Außen-Sehens technisch zu realisieren.

Fazit

Nach dem Wissenschaftstheoretiker Karl Popper erweist sich eine Hypothese dann als falsch, wenn sie durch Beobachtungen widerlegt werden kann. Diese Falsifizierung ist offen. Eine Weiterentwicklung der gegenwärtigen KI ist aber ohne die Erzeugung von maschineller Wahrnehmung nicht zu erwarten. Heute kann kein Roboter durch seine Kameras hindurch in die Außenwelt blicken, in Zukunft sollte das unmittelbare nach Außenschauen jedoch möglich werden. Eine vielleicht erschreckende Vorstellung, doch für viele Anwendungen von Drohnen und mobilen Robotern eine zwingende Fähigkeit.

Literatur

[1] Hertig et al. (2014), Hypercomplex Algebras and their application to the mathematical formulation of Quantum Theory, https://doi.org/10.48550/arXiv.1406.1014

[2] Otte (2024), On possible advantages of conscious systems and a Turing Test for Consciousness, Adv. Artif. Intell. Mach. Learn., 4 (4 ):3186-3201, https://dx.doi.org/10.54364/AAIML.2024.44183

[3] Otte (2025), Beyond algorithm-based AI concepts. Consciousness and its generation on machines, Melusina Press, Universität Luxemburg, doi: 10.26298/1981-5791-baac