„Der größte Aufwand bestand darin, an fehlerhafte Daten zu kommen“

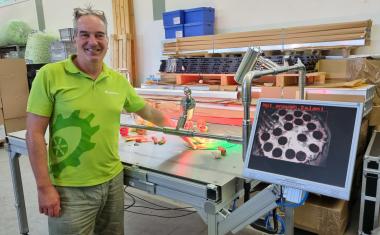

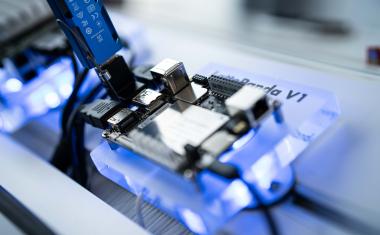

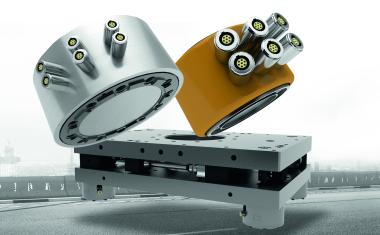

Fehlerhafte Teile automatisch zu erkennen, ist das Ziel. Wie man jedoch einem Inspektionssystem die Merkmale von Gut- und Schlechtteilen beibringt, damit haben sich Mario Bohnacker, Technical Product Manager Halcon bei MVTec, und Bernd Sattler, Abteilungsleiter Bildverarbeitung bei Manz, beschäftigt. Heraus kam eine effiziente Qualitätssicherung für das modulare Lasersystem BLS 500 von Manz, mit dem Batterien hergestellt werden.

Was war die größte Schwierigkeit des Projekts, die Sie überwinden mussten?

Bernd Sattler: Der größte Aufwand bestand darin, überhaupt an Daten, im Speziellen an fehlerhafte Daten zu kommen. Diese waren aber zum damaligen Zeitpunkt unbedingt erforderlich, damit die Software anhand der Schlechtbilder entsprechend lernen konnte. Hierzu mussten wir Strategien entwickeln, wie sich solche Fehler simulieren lassen. Nachdem wir diesen Prozess zunächst bei uns inhouse gestartet hatten, folgte im zweiten Schritt die Aufnahme von Daten bei einem Kunden vor Ort.

Mario Bohnacker: Dieser Aufwand war insofern notwendig, da der Schlüssel für eine erfolgreiche Deep-Learning-Applikation nicht – wie man meinen könnte – die zu 100 Prozent richtigen Parameter oder eine spezielle Netztopologie sind, sondern die Qualität der Daten. Diese beeinflusst direkt die Qualität des Ergebnisses.

Wie lange dauerte es vom Projektbeginn bis zum Erkennen des ersten fehlerhaften Schweißpunkts?

Sattler: Vor allem das Sammeln, Annotieren und Vorbereiten der Trainingsbilder, um einen validen und ausgewogenen Datensatz zu erhalten, war sehr aufwändig. Deshalb dauerte es etwa vier bis fünf Monate, bis das System einsatzfähig war. Den Hauptaufwand verursachten dabei das Trainieren der Modelle und die notwendigen Anpassungen.

Bohnacker: Genau. Der Großteil des Aufwandes liegt tatsächlich im Generieren, Organisieren und Labeln der Datensätze. Hier ist große Sorgfalt geboten, da – wie bereits erwähnt – die Qualität des Datensatzes direkt Einfluss auf die Qualität der Ergebnisse nimmt.

Warum kam die „Anomaly Detection“ nicht bei der Testreihe des Defokus-Fehlers zum Einsatz?

Sattler: Weil es dieses Feature zum Zeitpunkt des Projektbeginns noch nicht gab. Wir haben später auch Anomaly Detection an anderen Daten angewendet. Aber wir hatten den Eindruck, dass diese Technologie noch nicht so weit fortgeschritten und ausgereift war wie die Klassifizierungsmodelle. Anomaly Detection ist ein guter Weg, wie sich schneller Fortschritte in der Produktion erzielen lassen. Gute Teile zu produzieren, ist deutlich einfacher als fehlerhafte. Da wir auf Produktionsdaten zugreifen können, geht auch die Datenerhebung deutlich schneller. Fehlerfälle muss man erst absichtlich herbeiführen oder die Nadel im Heuhaufen suchen.

Bohnacker: Zu beachten ist auch, dass beide Technologien jeweils für andere Anforderungen entworfen wurden. Die Klassifikation eignet sich hervorragend für Applikationen, in denen Fehlertypen/Klassentypen bekannt sind oder – wie im Fall von Manz – es möglich ist, Bilder für Fehlerfälle zu erzeugen. Das Modell lernt, die trainierten Fälle sehr gut zu unterscheiden. Anomaly Detection hingegen wurde für Szenarien entwickelt, in denen die mögliche Varianz nicht abgebildet werden kann, also nicht genügend Bilddaten von typischen Fehlern vorhanden sind. Das Modell lernt, Abweichungen vom Soll zu erkennen, die in jeglicher Form auftreten können. Der Vorteil von Anomaly Detection liegt also darin, dass unbekannte Fehler erkannt werden. Sind jedoch alle möglichen Abweichungen bekannt und genügend Bilddaten vorhanden, empfiehlt es sich, mit der Klassifikation zu arbeiten.