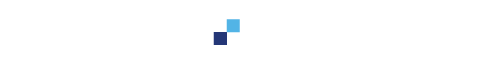

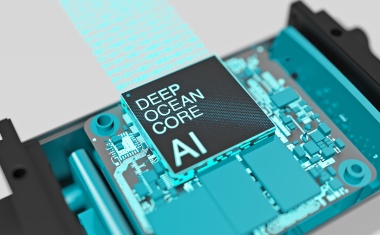

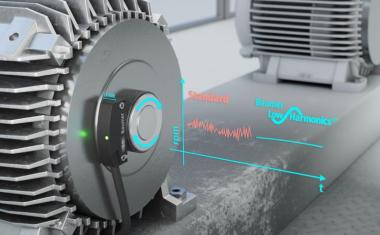

Künstliche Intelligenz – sowohl Training als auch die eigentliche Inferenz – konnte bisher hauptsächlich für Rechenzentren entwickelt werden. Dieser Trend verändert sich jedoch aktuell. Wenn die Inferenz direkt auf den bildgebenden Geräten selbst stattfinden soll, werden die Dinge interessant. Wie lässt sich eine derart leistungshungrige Technologie außerhalb von großen Rechenzentren in den kleinen ressourcenoptimierten Embedded-Geräten effizient und nachhaltig einsetzen? Es gibt bereits einige funktionierende Ansätze und Lösungen, um Neuronale Netze auf Edge-Geräten effizient zu beschleunigen. Aber nur wenige sind flexibel genug, um mit der schnell fortschreitenden KI-Entwicklung Schritt zu halten.