Multikamera-System ermöglicht Teleoperation von Schreitbaggern

Mobile Arbeitsmaschinen in heiklen Einsätzen

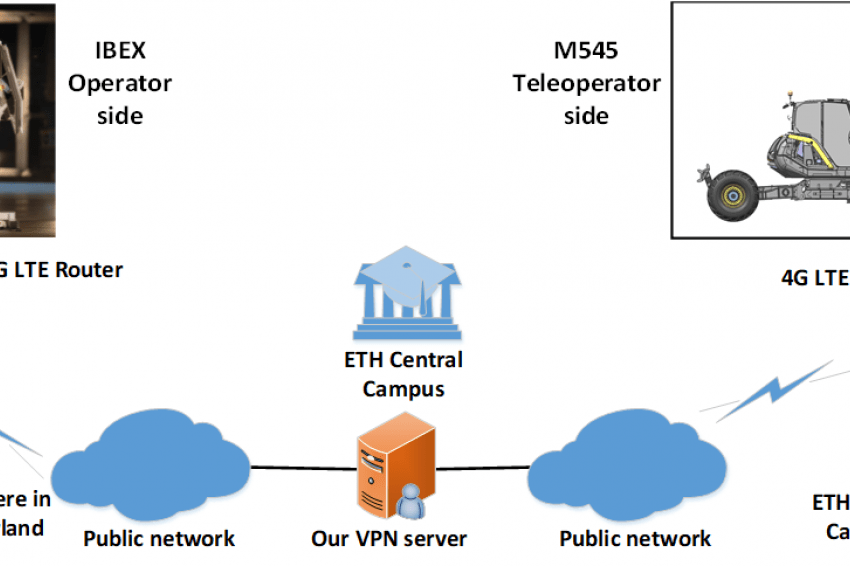

Manche Arbeiten sind für Menschen so gefährlich, dass man stattdessen Maschinen vorschickt. Ein Hersteller von Schreitbaggern, ein Kamerahersteller, ein Forschungsinstitut sowie mehrere weitere Unternehmen taten sich zusammen, um einen Bagger mithilfe von VR-Brille und Bewegungssimulator über Mobilfunk fernzusteuern. Das Projekt verlief erfolgreich. Und schon überlegen die Beteiligten, wie sich die Möglichkeiten durch immer bessere Technologien noch erweitern lassen.

Mit der technologischen Weiterentwicklung der drahtlosen Kommunikation wie 5G, Visualisierungstechnologien wie Virtual Reality (VR), Steuergeräten und Sensoren ist es heute möglich, die Ausbildung zur Bedienung von Maschinen in einer virtuellen Umgebung durchzuführen sowie Maschinen von entfernten Standorten aus zu bedienen (Telebetrieb).

Die ETH Zürich arbeitet derzeit an einem Projekt, dessen Ziel es ist, einem Maschinenführer eine präzise und realistische Arbeitsumgebung zu vermitteln (in diesem Fall die Bedienung eines Baggers). Der Maschinenführer hat dabei Zugang zu allen relevanten Informationen in derselben Form, als säße er im Cockpit des Baggers. Darüber hinaus kann er zusätzliche semantische Daten erhalten, die im Bagger nicht verfügbar wären. Somit lässt sich die Effizienz im Telebetrieb gegenüber der lokalen Bedienung sogar noch erhöhen.

Rahmenbedingungen und Vorzeigeprojekte

Einige der ersten Anwendungen fanden in Form von Messepräsentationen und Baggerführerschulungen in speziellen Laboren statt. Auf der Bauma 2019 hat Menzi Muck, Hersteller von Schreitbaggern, in Zusammenarbeit mit der ETH Zürich erstmals einen ferngesteuerten Bagger vorgestellt. Bei einer Outdoormesse wie der Bauma können die realen Arbeitsbedingungen, wie Witterung, schwankende Luftfeuchtigkeit und sich verändernde Sonneneinstrahlung, dargestellt werden. Die Live-Demonstration bestand aus einem Menzi-Muck-Simulator-Set (inklusive VR-Brille), das mit einem Bagger in einer anderen Stadt verbunden war, um den Maschinenführer zu schulen. Der Bagger ist mit einem Multikamera-System ausgestattet, basierend auf Industriekameras von Ximea. Die Kameras verwenden eine Bildverarbeitungslösung mit niedriger Latenz auf einer Nvidia-Jetson-TX2-Plattform, bereitgestellt von MR-Tech. Dieses System ermöglicht es, sich an die Außenumgebung anzupassen. Die Belichtungszeit der Kameras richtet sich automatisch auf die sich ändernden Wetterbedingungen ein.

Heap: ein autonomer Hydraulikbagger

In diesem Fall wurde der Bagger Heap verwendet: ein Menzi Muck M545-Bagger, der für autonomes und ferngesteuertes Arbeiten konstruiert wurde. Die Maschine verfügt über kraftgeregelte Hydraulikzylinder im Fahrgestell, die es ermöglichen, die Maschine an jedes Gelände anzupassen. Zusätzlich verfügt der Heap über für den Betrieb notwendige Sensoren, zum Beispiel Laserscanner (Lidar), Beschleunigungs- (IMU), Niveau- (GNS) und Gelenksensoren. Die primäre autonome Nutzung ist die robotergestützte Landschaftsgestaltung, die im Rahmen eines Programms des Nationalen Forschungsschwerpunktes (NFS) Digital Fabrication (dfab) untersucht wird.

Ferngesteuerte Echtzeitübertragung

Das ETH-Team entwickelte in Zusammenarbeit mit MR-Tech, dem offiziellen Systemintegrator von Ximea-Kameras, ein auslösbares Videoübertragungssetup. Die Kollaboration mit MR-Tech entstand durch den Wunsch, ein Streaming in voller Auflösung mit den Kameras zu erreichen. Dafür wurden folgende Hardwarekomponenten verwendet:

- Nvidia Jetson TX2 + Trägerplatte;

- 2x Ximea PCIe xiX Kameras mit 2.064 x 1.544 Pixel, 1/1.8” und 122 fps (218 fps max.);

- Theia MY125M Weitwinkel-Linsen (optisch korrigiertes Fisheye ~150°);

- Gremsy T3 Gimbal verbunden mit der VR-Brille HTC Vive;

- Arduino-Nano, um den HW-Auslöser bei den Kameras zu triggern.

Dieses Setup läuft auf Ubuntu 16.04 und verwendet die GPU-beschleunigte Bildverarbeitung und Videokompression (derzeit H.264) im Stereo-Videostream. Derzeit ist die erreichbare Auflösung 1.416 x 1.416 Pixel bei 40 fps oder 80 fps mit verschachtelter Ereignisdarstellung.

Die Auflösung und Framerate lässt sich durch ein anderes Kameramodell und insbesondere durch zukünftige Updates der Nvidia Jetson auf die AGX-Xavier-Version erhöhen.

Das Kamerastabilisierungsgerät Gremsy Gimbal kommt normalerweise für stabilisierte Aufnahmen zum Einsatz. Die ETH hat diesen in einen positionsgesteuerten Roboter umgewandelt, um die Kopfbewegungen des Menschen nachzuempfinden. Erste Tests zeigten, dass die Stabilisierungseinheit für langsame Kopfbewegungen geeignet ist. Für schnellere Bewegungen kann der Maschinenführer eine signifikante Latenz erkennen.

Das Multikamera-System

MR-Tech hat ein modulares Multiplattform-Framework für Bildverarbeitung und industrielle Bildverarbeitungsanwendungen entwickelt, dass sich auf einen hohen Dynamikbereich und niedrigste Latenzzeiten konzentriert. Für dieses spezielle Projekt wurde für die Zusammenschaltung eine beschleunigte GPU-Verarbeitungskette auf der Nvidia-Jetson-TX2-Plattform mit Trägerkarte implementiert. Ein Wechsel zu AGX Xavier würde die Rechenleistung, Bandbreite und Bildwiederholungsrate erhöhen. Die aktuelle Verarbeitungskette beinhaltet folgende sieben Schritte:

- 8, 10 und 12 Bit-Bildaufnahme mittels der Ximea-Kameras;

- Schwarzwertabzug;

- Automatischer Weißabgleich;

- Demosaicing (Debayer);

- Konvertierung in das YUV-Format;

- H.264/H.265 Videokodierung;

- RTSP-Streaming.

Die Schritte zwei bis sechs werden mit einem Fastvideo Software Development Kit (SDK) unterstützt, das auf einer GPU läuft. Zusätzlich wendet die Prozesssteuerung einen asynchronen Auto-Exposure-Algorithmus an, um die Kameraeinstellungen an die Lichtverhältnisse anzupassen. Und schließlich, wenn die beiden Xix-Kameras gleichzeitig Bilder erfassen (mit Hardwaresynchronisation), fügt das System eine Latenz von 15 ms für die obigen Verarbeitungsschritte hinzu. Eine Gesamtlatenzzeit von Glas zu Glas sollte je nach Netzwerkparameter 60 ms nicht überschreiten. Die Kommunikationsumgebung ist ein 4G/5G-Netzwerk.

Ibex-Bewegungsplattform

Ein weiterer Teil des Setups ist Ibex, entwickelt für den Heap, um präzise Bewegungen und visuelles Feedback zu liefern. Es handelt sich um eine Nachbildung des Heap-Cockpits, welches auf einer 3-DoF-Bewegungsplattform (3 Degrees of Freedom) aufgebaut ist. Die Bewegung des Baggerfahrgestells und die Bewegung der Plattform sind synchron gekoppelt, sodass der Baggerführer sämtliche Bewegungen des Baggers mitbekommt, so als säße er tatsächlich in dessen Cockpit. Dies ist essenziell, denn die Bediener verlassen sich stark auf ihr Bewegungsempfinden, um abzuschätzen, ob alle vier Räder auf dem Gelände Bodenkontakt haben oder nicht.

Bei dem ersten Entwurf von Ibex liefern drei Monitore das visuelle Feedback der drei Live-Kamerastreams, die das Frontfenster und zwei Seitenfenster darstellen. Als Erweiterung werden die Monitore durch ein Head Mounted Display (HMD) mit HTC Vive ersetzt, um den Maschinenführer vollständig visuell in eine Fernprojektion der realen Position des Baggers zu versetzen. Dies ermöglicht es dem Bediener, ein wahres Gefühl des Eintauchens zu erleben, denn das HMD verbessert die Wahrnehmung des dreidimensionalen Raumes. Die Bildqualität, die Sehschärfe und das Sichtfeld für die Bediener könnten sich sogar verbessern, wenn das HTC Vive durch XTAL ersetzt wird.

Visualisierung

Wie bereits erwähnt arbeitet das aktuelle System mit dem HTC-Vive-Headset. Für die virtuelle Realität wird das XTAL VR Headset von VRgineers in Betracht gezogen, welches ein Sichtfeld von 180 Grad mit kristallklarem Bild bietet. Dies wird durch die Kombination von zwei OLED-Panels mit einer Gesamtauflösung von 5.120 x 1.440 bei 70 Hz erreicht.

Der Anschluss an einen Computer erfolgt über 1x Displayport 1.2, 1x USB und 1x Netzkabel. XTAL bietet derzeit folgende Funktionen:

- Open-VR-Unterstützung;

- Unterstützung der Arbeit mit Nvidia VR;

- Testen des Eye Tracking (30 fps);

- Handverfolgung über einen Leap-Motion-Sensor;

- Unterstützung für AR-Tracking, Lighthouse-Tracking, Optitrack-Tracking, Startrack-Tracking.

In naher Zukunft wird das Angebot um diese Funktionen erweitert:

- Linux-Unterstützung;

- schnelleres Eye Tracking (120 fps);

- rechtsseitiges elektromagnetisches Tracking (bis zu 2 m, jedoch nur für Anwendungen im Sitzen geeignet);

- Frontkameras als Zusatzmodul;

- Foveated Rendering.

Rucksackcomputer als kompakte Teleoperationslösung

Zukünftige Anforderungen könnten darauf beruhen, den Bagger ohne Einsatz von Ibex zu steuern, wenn der Bediener alle notwendigen Ausrüstungen für den Telebetrieb der Maschine bei sich trägt. Diese Konfiguration wäre auch für die Telebedienung kleinerer Maschinen sinnvoll und ermöglicht die Integration des Kamerasystems. Eine solche mobile Bedienstation ist auch für die teil- und vollautonome Führung bei Mixed-Reality von Bedeutung.

Der HP Z VR-Rucksackcomputer lässt sich als klassischer Rucksack tragen und wurde sowohl mit dem HTC Vive als auch dem XTAL getestet. Er bietet ausreichend Leistung und Zuverlässigkeit, in Verbindung mit austauschbaren Batterien und einer Desktop-Dockingstation. Weitere Spezifikationen:

- Intel i7 782720HQ (2.9/3.9GHz);

- 16 GB RAM DDR4;

- Nvidia Quadro P5200;

- SSD 256;

- Ubuntu 16.04;

- SteamVR + OpenVR auf Linux.

Projektpartner

ETH Zürich, Robotic Systems Lab (RSL): Das Robotic Systems Lab untersucht die Entwicklung von Maschinen und deren Intelligenz für den Einsatz in rauen und anspruchsvollen Umgebungen.

Mit einem großen Fokus auf Roboter mit Armen und Beinen umfasst die Forschung Ansteuerungsverfahren für fortschrittliche dynamische Interaktionen, innovative Designs für mehr Systemmobilität und Vielseitigkeit sowie neue Steuerungs- und Optimierungsalgorithmen für Fortbewegung und Manipulation.

VRgineers: VRgineers ist spezialisiert auf die Entwicklung von Virtual- und Mixed-Reality-Technologien. Das Unternehmen stellt Quellcodes des Duplex-Players für bestimmte Projekte zur Verfügung. Die ETH empfiehlt diesen benutzerdefinierten Videoplayer, der stereoskopische Videostreams mit einer Auflösung von bis zu 16K wiedergeben kann.

MR-Tech: MR-Tech entwickelt plattformübergreifende Software für industrielle Bildverarbeitungssysteme. Das Unternehmen ist zudem Distributor sowie Technologie- und VAR-Partner von Ximea.

Fastvideo Imaging Software: Die Echtzeitverarbeitung von Fastvideo bietet eine H.264/H.265-Kodierung und Streaming inklusive Schwarzwerten, Weißabgleich, Demosaicing, Auto-Belichtung und vieles mehr.

Ximea: Ximea entwickelt und vertreibt industrielle sowie wissenschaftliche Kameras. Von Hochleistungskameras, über Embedded- und Multikamerasystemen bis hin zu Hyperspektralkameras bietet das Unternehmen spezialisierte Produkte auch für anspruchsvolle Anforderungen.