Assistenzsysteme zur Bewertung des Abwasserkanalsystems – Perspektiven durch BV und maschinelles Lernen in der Bildauswertung

07.03.2019 -

550.000 Kilometer umfasst das Kanalnetz in Deutschland – knapp 10.000 Kilometer davon verlaufen in Berlins Erdreich. Um das Rohrsystem regelmäßig und wirtschaftlich überprüfen zu können, startete vor gut zwei Jahren das BMBF-Projekt Auzuka. Mittels (teil)automatisierter Bildauswertung können Schäden automatisch erkannt und in Schadenklassen eingeteilt werden.

Vor dem Hintergrund der demografischen und klimatischen Veränderungen steht die zukünftige Abwasserentsorgung städtischer Gebiete vor neuen Herausforderungen. Dazu gehört auch die Kenntnis über deren Zustand. Es besteht daher die Notwendigkeit zur zeitnahen und qualitativ hochwertigen Zustandsbewertung mittels Inspektion. Der Fokus der Forschung im Bereich Kanalisation liegt unter anderem in der Entwicklung intelligenter Systeme innerhalb der Abwasserinfrastruktur und einer nachhaltigen Bewirtschaftung. Das Kanalnetz in Deutschland umfasst rund 550.000 Kilometer. Um dessen Funktion sicherzustellen, muss dieses inspiziert und im Bedarfsfall saniert werden. Der Forschungsverbund Auzuka (Automatisierte Zustandsanalyse von Abwasserkanälen durch virtuelle Begehung) entwickelt gemeinsam einen neuartigen Kamerasensorkopf sowie eine Methode, wie mit Hilfe von Neuronalen Netzen Beschädigungen im Kanalnetz automatisch assistiert erfasst und kategorisiert werden können. Denn bislang muss jeder Quadratmeter noch von Menschen kontrolliert werden, was ebenso kostenintensiv wie fehleranfällig ist.

Das Projekt Auzuka

2016 startete das BMBF-Projekt Auzuka unter der Leitung der Berliner Wasserbetriebe, Bereich FuE. Von der gesamten Kanalnetzlänge in Deutschland laufen rund 9.700 Kilometer durch Berlin. Geprüft wird das Rohrleitungsnetz regelmäßig mit einer exakten Bildauswertung. Die Dokumentation der Kanalisation erfolgt bislang mit Hilfe eines Roboters, der Bilder über den Zustand der Kanäle liefert. Um ein wirtschaftlich einsetzbares System zu gewährleisten, müssen die Technologien den Stand der Technik übertreffen. Die Spezifikation dafür geben die Berliner Wasserbetriebe vor: Weniger als 10 Prozent relevanter Schadensfälle sollen manuell zugeordnet werden. Das FE-Projekt Auzuka lokalisiert Problemschwerpunkte im Bereich der Abwasserableitung und schlägt Lösungsansätze vor. Die (teil)automatisierte Bildauswertung orientiert dabei die automatische Erkennung von Schäden und Einbauelementen in Kanalhaltungen sowie die Schadensklassifikation. Zusätzlich erfolgt die Bilderkennung in Kombination des maschinellen Lernens mit klassischen Ansätzen [1].

Die Projektziele sind:

- ein Assistenzsystem zur Produktivitätssteigerung und Qualitätssicherung,

- die Steigerung der Tagesleistung durch

- (hoch)automatisierte Bildauswertung Datenbestand (Digit Fisheye)

- Unterteilung Schadenfreiheit / Sanierungsbedürftigkeit

- neue Sensortechnik (ab DN 200) / Funktionsmuster

- 3D - Bild-Erstellung und verbesserte Positionsgenauigkeit,

- Identifikation relevanter Schäden,

- Schadensklassifikation.

Die Berliner Wasserbetriebe sind als wasserwirtschaftlicher Akteur im Projekt gleichzeitig Bedarfsträger und wissenschaftlicher Praxispartner. Sie erarbeiten zusammen mit den Verbundpartnern technische Lösungsansätze zur automatisierten Bildauswertung als Assistenzsystem und einem neuartigen Kamera-Sensorkopf und bewerten deren Einsatzmöglichkeiten im Bereich der Kanalinspektion. Das Projekt wird gefördert vom Bundesministerium für Bildung und Forschung im Bereich Photonik (Förderkennzeichen 13N13892).

Das Inspektionssystem

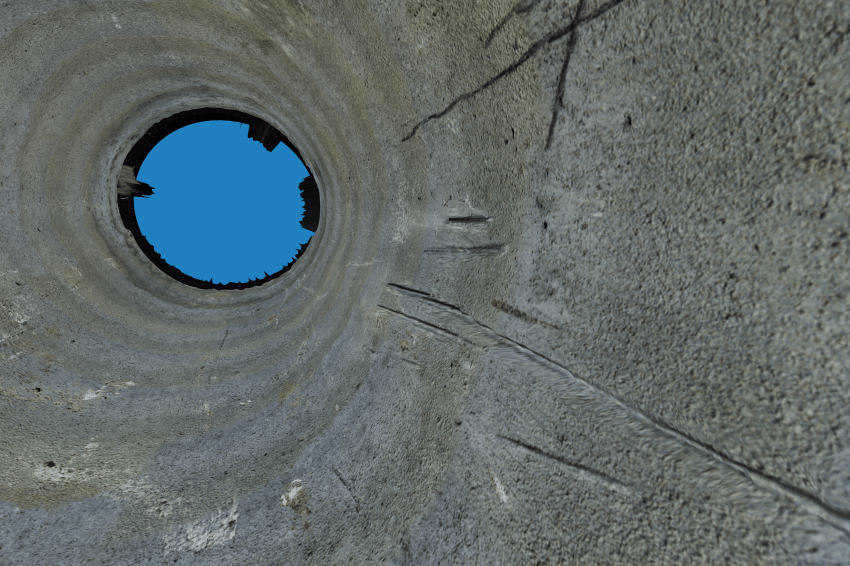

Die Inspektion der Kanalnetze ist eine wichtige Aufgabe, um die Funktion des Kanalnetzes sicherzustellen. Die Herausforderung dabei: Auch die Auswertungen der Kameraaufnahmen muss durch Fachexperten von Hand durchgeführt werden. Neben Zeit- und Kostenintensität liegt der Anteil an unterschiedlicher Zustandsklassifizierung bei doppelt inspizierten Kanalhaltungen bei rund 55 Prozent [2]. Vor diesem Hintergrund arbeitet das Auzuka-Verbundteam an der automatischen Erkennung von Schäden wie unter anderem Rissen, Scherben oder Wurzeleinwuchs, um die Fehleranfälligkeit des Menschen bei dieser monotonen Arbeit zu senken. Für die Schadenserkennung, Bewertung und Vermessung wird daher ein intelligentes Mehrkamerasystem entwickelt, das zur zukünftigen 3D-Rekonstruktion des Kanals in einen Inspektionsroboter implementiert wird und 3D-Daten erzeugt, die anschließend automatisch ausgewertet werden.

Digitalisierung der Bilddaten

Der Inspektionsroboter nimmt die Daten zyklisch während seiner Fahrt durch das Kanalnetz auf. Die Ansteuerung der Sensorik und der Beleuchtung ist so ausgelegt, dass eine großzügige Überlappung der Bilder gegeben ist, um ein robustes Wiederzusammensetzen der Einzelaufnahmen (Stitching) in den Nachverarbeitungsschritten zu gewährleisten. Die hierfür notwendigen Positionsdaten werden von einem Odometriemodul geliefert. Es bedarf unterschiedlicher Beleuchtungsmodi, die sequenziell durchgeschaltet werden. Die homogene Beleuchtung dient der Texturbild- und eine strukturierte Beleuchtung der Musterbildaufnahme, das heißt Projektion von speziellen codierten Mustern zur Erfassung von 3D-Informationen.

Bilddatenverarbeitung

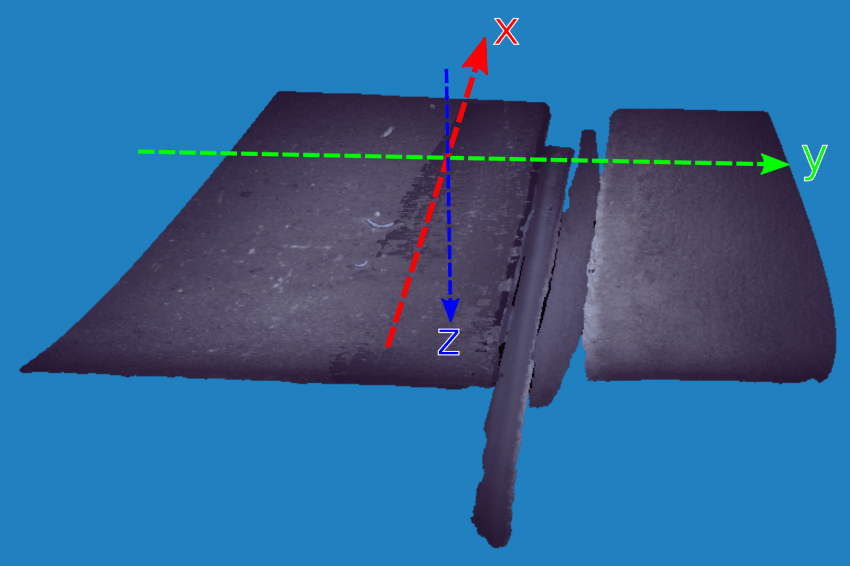

In einem der ersten Verarbeitungsschritte werden die zeitlich nacheinander aufgenommenen Textur- und Musterbilder unter Berücksichtigung einer kontinuierlichen Fahrbewegung mit einander registriert, so dass jedem Texturpixel ein Pixel im Musterbild eindeutig zugeordnet werden kann. Gegebenenfalls werden Algorithmen zur Glanzreduktion ausgeführt. Aus den Musterbildern werden unter Einbeziehung der vorkalibrierten Parameter der Sensor-Beleuchtungs-Module mittels Verortung der bekannten Muster und Triangulation die Tiefendaten erzeugt. Es folgen weitere Verarbeitungsschritte wie Ausreißer-Ermittlung, Interpolation oder Fusion mit den unmittelbar benachbarten und sich überlappenden Bild-Messbereichen, die zuvor miteinander dreidimensional registriert werden müssen. Für die Registrierung wird ein feature-basierter Ansatz unter Einbeziehung der Texturinformationen verfolgt [3], der sich initial auf die Lageinformationen des Odometriemoduls stützt. Durch den Fusionsschritt erhält das resultierende Tiefenbild eine höhere Punktdichte und es werden gegebenenfalls Lücken in den Messdaten ausgefüllt.

Die hochauflösenden Bilder der einzelnen Kameramodule müssen in Verbindung mit den gemessenen Tiefendaten zu einem konsistenten 3D-Modell des gesamten Rohres fusioniert werden. Das Modell dient anschließend einerseits dem technischen Fachpersonal zur Beurteilung von Schäden sowie auch dem KI-Modul zur automatischen Zustandsbeurteilung.

Das Rohr wird daher mit einem einfachen Trianglemesh modelliert, Abweichungen von dieser idealisierten Geometrie werden in einer Displacement-Map hinterlegt. Dieses Vorgehen resultiert zum einen in einem hinreichend kleinen Modell, welches sich effektiv und visuell ansprechend darstellen lässt. Des Weiteren lässt sich so unser bereits publizierter Ansatz für reine Texturdaten [4] unkompliziert um die zusätzliche Tiefeninformation erweitern. Wie zuvor fußt die Registrierung auf einem feature-basierten Ansatz. Die Anbindung der Teilsegmente erfolgt jedoch auch über den Rohrumfang, weshalb ein iterativer Matching-Ansatz [5] sowie eine gezielte Modellierung der Beleuchtung nötig sind. Mit der Methode der kleinsten Quadrate und einer nichtlinearen Modellfunktion wird die optimale Position für alle Teilsegmente ermittelt.

Bildauswertung

Die Bilddaten werden mit einem speziellen Neuronalen Netz dem Retina-Netz ausgewertet. Um die künstliche Intelligenz zu trainieren, muss diesem aber zuvor mitgeteilt werden, wie zu klassifizierende Schäden überhaupt aussehen. In sogenannten Trainingsdaten werden dafür Schäden markiert und als Input verwendet. Das Netz lernt nun Zusammenhänge durch wiederkehrende Gemeinsamkeiten der Daten und abstrahiert dieses Wissen auf neue untrainierte Bilder, um dort Schäden zu detektieren.

Um in der Schadensklassifikation eine hohe Genauigkeit zu erreichen, werden einige Schäden pixelgenau markiert. Da dieses Vorgehen jedoch für die benötigten großen Mengen an Trainingsdaten nicht sinnvoll ist, wird zusätzlich ein Netzwerk trainiert, das nur einen groben Rahmen um den Schaden legt, eine sogenannte Bounding-Box. Bestandsdaten der manuellen Auswertung können so genutzt und neue deutlich schneller generiert werden.

Zur Schadenserkennung wird gewonnenes Bildmaterial aus dem neuartigen Kamera-Sensorkopf sowie aus Aufnahmen mit bestehender Fisheye-Technologie [4] genutzt. Die Herausforderung liegt nun darin, alle Ansätze sinnvoll zu einem Hybridsystem zu verknüpfen, um eine effiziente und gleichzeitig detaillierte Erkennung zu ermöglichen.

Ausblick

Zukünftig werden zur automatisierten Bilderkennung auch Heuristiken und die Kombination mit klassischen Ansätzen bewertet werden. Die KI wird bei der Begutachtung durch Experten dann zu einer Assistenz, wenn mit hoher Trefferquote Schadensklassifizierungen je nach Art und Ausmaß markiert zur Verfügung gestellt werden. Mittelfristig kann Auzuka dann den Grundstein für eine automatisiert assistierende und treffsichere Kontrolle der wohl wichtigsten deutschen Infrastruktur legen.

Kontakt

Berliner Wasserbetriebe

+49 30 8644 2438