3D besser wahrnehmen

3D-Vision wird zunehmend in Verbindung mit maschinellem Lernen in vielen Anwendungsbereichen eingesetzt. Neueste COM-HPC-Module bieten diesen Applikationen nicht nur eine signifikant höhere Rechenleistung, sondern helfen auch bei der Hardwarekonsolidierung. Wie genau, erfahren Sie auf den nächsten Seiten.

Mit einem jährlichen Wachstum von nahezu 15 Prozent ist 3D-Vision auf dem Vormarsch. Dafür sind zwei Faktoren entscheidend: Zum einen nimmt der Anteil der arbeitsfähigen Bevölkerung ab, zum anderen steigt der Anteil derer, die medizinische Versorgung benötigen. Da es weniger Arbeitskräfte gibt, werden also in beiden Bereichen mehr Roboter benötigt. Sie bieten der fertigenden Industrie eine deutlich höhere Produktionseffizienz und im Gesundheitswesen können sie Menschen zu mehr Autonomie und Mobilität verhelfen.

Zukunftsaussichten

Bevor Roboter jedoch schwere Arbeiten übernehmen können, ist noch viel Entwicklungsarbeit zu leisten. So sind beispielsweise Inspektionssysteme meistens statisch an einem Ort verankert. Auch wenn sich der Markt der Vision Guided Robotics (VGR) höchst dynamisch entwickelt, ist deren Mobilität noch recht begrenzt. Stationäre Roboter müssen für ihre Arbeitsaufgaben zuerst Dinge in ihrem Umfeld genau erkennen. Durch den Einsatz von 3D-Kameras gelingt ihnen dies deutlich effizienter, da sie Objekte aus allen drei Achsen identifizieren und vermessen können. Der Wunsch nach mehr Flexibilität treibt das Wachstum in der diskreten Fertigung voran – vor allem durch den Trend der Industrie 4.0 hin zur Losgröße 1.

Für die Zuführungs- und Ausgabesysteme in der diskreten Fertigung werden zunehmend Vision Guided Robotiksysteme und Automated Guided Vehicles (AGV) eingesetzt. Kaum verwunderlich, dass für sie bis 2028 eine Wachstumsrate von jährlich 13 Prozent prognostiziert wird. Fest installierte Fördersysteme zum Bewegen und Transportieren von Produkten werden zunehmend von AGVs ersetzt. Dank ihrer Mobilität blockieren sie im Gegensatz zu fest installierten Fördersystemen keine Hallenfläche und optimieren die Lagerhaltung, Warenkommissionierung und -transport. In Kombination mit VGR-Systemen werden sie sogar zu mobilen Pick-and-Place-Robotern.

Modularität ist entscheidend

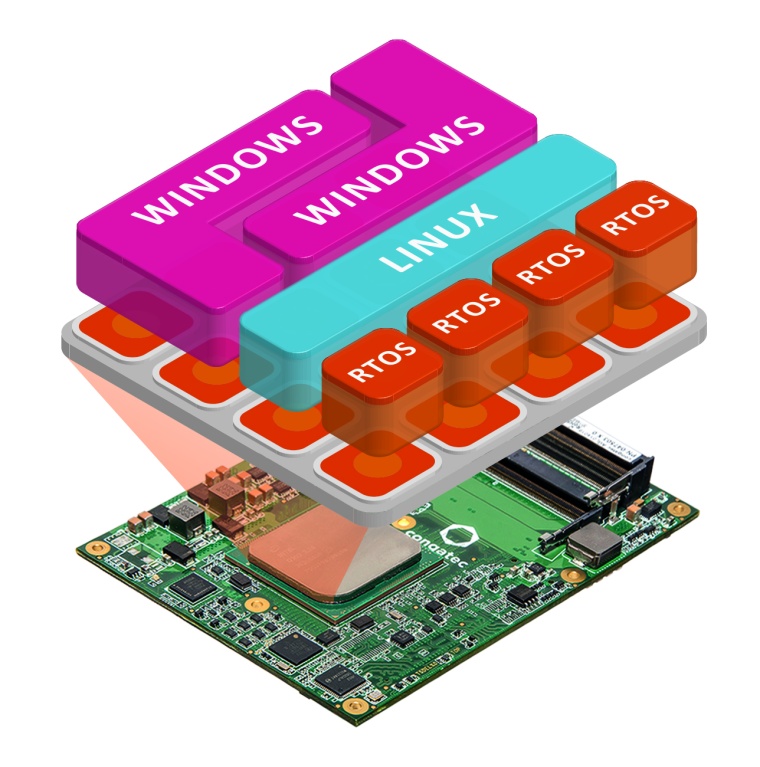

Fortschrittliche mobile Robotersysteme nutzen dabei häufig mehrere Subsysteme. Ein Beispiel ist ein vierbeiniger mobiler Roboter, der insgesamt drei Computer-on-Modules nutzt, dem jeden eine spezifische Aufgabe zugeordnet ist: Umgebungserkennung, Bewegungssteuerung und Aufgabenausführung. Dieses Beispiel verdeutlicht die Vorteile von Computer-on-Modules, da jedes Modul individuell auf seine spezifische Aufgabe hin skaliert werden kann. Möglich ist es aber auch, die verschiedenen Steuerungen einer Fertigungszelle in einem einzigen System zu konsolidieren und in Echtzeit über Zweidraht-Ethernet mit den Aktoren und Frequenzumrichtern der Antriebe zu kommunizieren. Dafür sind jedoch Module mit deutlich mehr Performance und einer ausgereiften Plattformstrategie erforderlich. Um die erforderliche Rechenleistung zu erbringen und den Echtzeitbetrieb zu gewährleisten, benötigt der oben genannte Roboter übrigens zehn Prozessorkerne auf drei Modulen. Ein solcher Prozessor war für mobile Embedded Systems mit sehr geringem Stromverbrauch bis vor kurzem allerdings noch nicht erhältlich.

Mehrzweckcomputer mit mehr Cores

Mit der Veröffentlichung der COM-HPC Spezifikation durch das PICMG werden nun allerdings Computer-on-Modules verfügbar, die gegenüber aktuellen COM-Express-Modulen wesentlich mehr Schnittstellen, Bandbreite, Speicher und Rechenkerne bieten. Das gilt schon bei den neuen COM-HPC Client Modulen, viel mehr allerdings noch für den Server-Bereich, wo zukünftig robuste und skalierbare COM-HPC Server Module mit gelöteten Entry Class Serverprozessoren verfügbar sein werden. Dies ermöglicht die Konsolidierung vormals dezentraler Echtzeit-Steuerungssysteme auf Multi-Purpose Embedded Edge-Computer-Lösungen. Benötigt werden dafür allerdings echtzeitfähige virtuelle Maschinen, wie sie sich mit Hypervisoren von Herstellern wie Real-Time Systems umsetzen lassen. Echtzeit-Hypervisor-Lösungen werden für eine unterbrechungsfreie, deterministische Echtzeitsteuerung benötigt – unabhängig davon ob auf demselben Prozessor das HMI-Subsystem neu bootet oder eine leistungshungrige Auswertung und Konvertierung von Daten auf dem intergierten loT-Gateway stattfindet.

Steigender Performance-Hunger

Auch das rechenintensive 3D-Imaging kann die hohe Performance von COM-HPC gut gebrauchen, beispielsweise bei der Erstellung von Punktwolken. Sie werden mit der Time-of-Flight-Technologie (ToF) erfasst, die für jedes Pixel Raumkoordinaten mit einer Datentiefe von 32 Bit ausgibt. Bei einer Auflösung von 640 x 480 Pixeln und 30 Bildern pro Sekunde (fps) entstehen so pro Sekunde 35 Megabyte (MB) an 3D-Daten. Hinzu kommen noch die Farbinformationen einer klassischen 2D-Kamera, die in der Regel eine viermal höhere Auflösung hat und ebenfalls verarbeitet werden müssen. Bei 1,2 Megapixeln (1.280 x 1.024 Pixel) und 8 Bit Farbtiefe pro Kanal sprechen wir von zusätzlichen 112,5 MB pro Sekunde. Daraus ergeben sich pro Sekunde bis zu rund 150 MB an Daten, die auch jede Sekunde verarbeitet werden müssen. Ganz zu schweigen von der enormen Rechenleistung, die für zwei im Stereobetrieb arbeitende Kameras erforderlich ist. Diese Datenmengen stellen hohe Anforderungen an die benötigte CPU-/GPGPU-Rechenleistung. Dafür bietet sich die brandneue Generation der COM-HPC-Module mit Intel Core-Prozessortechnologie der 12. Generation (Alder Lake) an. Zu ihren Eigenschaften zählt der Support von PCIe 5.0, das im Vergleich zu PCIe 3.0 eine viermal höherer Bandbreite zwischen Prozessoren und Kameras sowie diskreten GPUs bereitstellt. Die native Unterstützung von MIPI-CSI-Kameras bietet weitere Vorteile, zum einen verringern sich dadurch die benötigte Verarbeitungsleistung als auch die Investitionen in die Kameratechnologie. Zudem unterstützen die Module über das Starterset konfigurierbare Netzwerkverbindungen, die von 1GbE und 2x 2.5GbE (mit TSN) bis hin zu Dual 10GbE reichen. Und mit Two-Wire-Ethernet können selbst kleinere Devices, wie zum Beispiel Aktoren und Sensoren, direkt über IP angebunden werden.

Umfassendes KI-Ökosystem

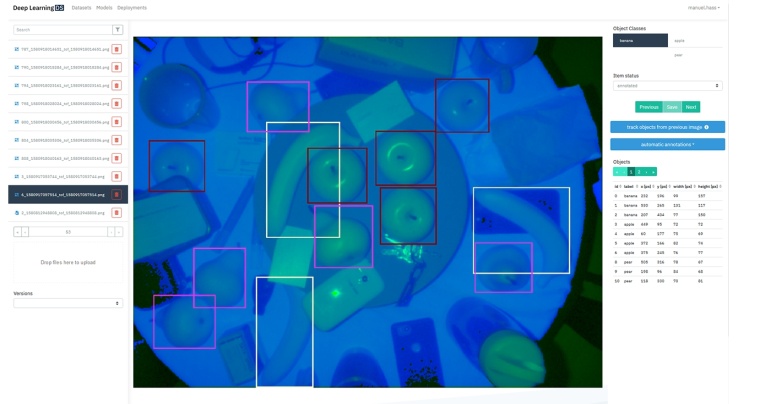

Congatec bietet darüber hinaus für IIoT- und Industrie 4.0-vernetzten Embedded-Systeme mit MIPI-CSI Kameras zusätzlichen Plug-and-Play-Komfort für KI-Applikationen. So unterstützen die Module eine KI- und Inferenz-Beschleunigung auf der CPU mittels Intel DL Boost basierter Vektor-Neural-Network-Instruktionen (VNNI) und auf der GPU mittels 8-Bit-Integer-Instruktionen (Int8). Auch die Kompatibilität mit dem Intel Open Vino-Ökosystem für KI sollte erwähnt werden. Das Autonomous System Lab der Intel Labs China hat bereits eine auf COM Express basierende Plattform für Schulungszwecke vorgestellt. Mit dieser HERO-Plattform können Ingenieure nun das OpenVINO-Ökosystem evaluieren – von den Softwarebibliotheken bis hin zur Adaptive Human-Robot Interaction (AHRI) oder Simultaneous Localization & Navigation (SLAM). Zudem gibt es auch schon ein Intel zertifiziertes „ready for Production“ Kit für die Workload-Konsolidierung.

Starterkit für die Systemevaluierung

Ideal für die Evaluierung neuer Smart-Vision-Robotertechnik und autonomer Logistikfahrzeuge ist das COM-HPC Carrierboard Conga-HPC/EVAL-Client im ATX-Formfaktor. Dieses verfügt über zwei hoch performante PCIe 4.0 x16-Schnittstellen und viele LAN-Optionen für individuelle Datenbandbreite, Übertragungsarten und Anschlüsse. Mit PCI Mezzanine-Karten (PMCs) kann der Carrier beispielsweise bis zu zwei 25GbE-Schnittstellen betreiben. Als Gehirn dient das COM-HPC Client Computermodul conga-HPC/cTLU-mit der 11. Generation der Intel Core Prozessoren im TDP-Bereich von 12 bis 28 Watt. Zukünftig werden auch Varianten mit der Intel Core Prozessoren der 12. Generation (Code-Name Alder Lake) verfügbar sein. Hier haben Entwickler die Wahl zwischen dem robusten Conga-HPC/cALP mit 45 Watt Intel Core Prozessoren sowie mit dem leistungsstarken Conga-HPC/cALS in der 65-Watt-Klasse.

Autor

Jürgen Jungbauer, Senior Product Line Manager

Anbieter

congatec AGAuwiesenstr. 5

94469 Deggendorf

Deutschland

Meist gelesen

Dieser Roboter steht Ihnen aber gut!

Über das Phänomen der Wearable Social Robots

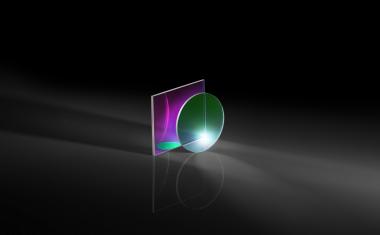

Shack-Hartmann-Sensor für Filtermessungen im Transmissionsband

Die Präzision optischer Anwendungen steigt, ebenso die Qualitätsanforderungen. Hersteller müssen Produktion und Messtechnik anpasen. Ein Shack-Hartmann-System bietet eine Lösung mit hoher Genauigkeit und Wiederholbarkeit

„Selbst die beste Hardware ist nur so gut wie die zugehörige Software“

Interview mit Martin Czommer, Produktmanager Machine Vision bei Di-Soric

Im Schlamm ruht sich ein großes Nilpferd aus

Virtuelle Video-Safaris für blinde und sehbehinderte Personen

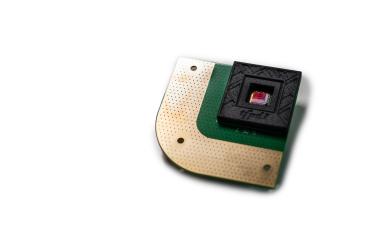

Umweltfreundliche Infrarotkameras

SWIR-Sensor mit bleifreien Quantenpunkt-Photodioden