Wie Datenaggregation bei der 24/7 Zustandsüberwachung unterstützt

Fokus auf die richtigen Daten

Der stetig zunehmende Ausbau von Rechen- und Speicherkapazitäten sowie die Entwicklung neuer Verfahren zur effizienten Datennutzung und -auswertung treiben die Verfügbarkeit und den Fluss von Informationen innerhalb unserer Gesellschaft in immer neue Höhen. Diese Entwicklung verändert derzeit auch den Betrieb von Maschinen. Ein Schwerpunkt ist in diesem Zusammenhang die Digitalisierung sowie die Zusammenführung und Verarbeitung von Sensor- und Betriebsdaten im Rahmen einer kontinuierlichen Zustandsüberwachung.

Das erklärte Ziel ist es hierbei, gefährliche Betriebsbereiche und damit Schäden zu vermeiden sowie Wartungen zu optimieren. Beispielhaft sind in Abbildung 1 schematisch die akkumulierten Betriebskosten einer Maschine über der Zeit aufgetragen, einmal mit und einmal ohne Zustandsüberwachung. Aufgrund des verbesserten Maschinenwissens konnte hier bei Einsatz einer Zustandsüberwachung der geplante Stopp effektiv zur Wartung genutzt und damit ein weiterer, ungeplanter Stopp vermieden werden. Gerade für komplexe Maschinen in kritischen Einsatzbereichen stellt eine 24/7 Zustandsüberwachung die geforderte hohe Verfügbarkeit sicher. Voraussetzung hierfür ist allerdings, dass die hierbei anfallenden enormen Datenmengen effizient verarbeitet und analysiert werden können.

Überblick über große Datensätze

Die digitale Aufzeichnung dynamischer Schwingungsdaten erzeugt sehr schnell große Mengen an Daten. Die Erfassung von Schwingungen bis 5 kHz erfordert beispielhaft eine Datenrate von mindestens 10.000 Samples pro Sekunde (S/s). Nimmt man an, jedes einzelne Sample erfordere 4 Byte an Speicher, so führt das zu einer Datenrate von 40 kByte/s, bzw. umgerechnet 144 MByte in der Stunde oder knapp 3,5 GByte am Tag. Im Allgemeinen wird für die Überwachung jedoch deutlich mehr als ein Sensor pro Maschine eingesetzt, da die Zusammenführung mehrerer Sensordatenströme den Kontext des Datensatzes erweitert und somit eine umfassendere Zustandsbeurteilung ermöglicht. Die Überwachung einer kompletten Maschine generiert also ein Vielfaches der oben genannten Zahl.

All dies erzeugt eine regelrechte Datenflut, was zahlreiche Herausforderungen mit sich bringt. So müssen etwa alle anfallenden Daten in Echtzeit so vorverarbeitet werden, dass sie sicher gespeichert und später effizient weiterverarbeitet werden können. Dies erfordert signifikante dedizierte Rechenkapazitäten. Zudem müssen für die Speicherung und Übertragung hinreichend leistungsfähige Medien und Netzwerke zur Verfügung stehen. Idealerweise wird auch die Datenqualität kontinuierlich sichergestellt, indem zum Beispiel zweifelhafte oder fehlerhafte Daten markiert oder ganz aussortiert werden. Sind die Daten einmal erhoben, bringt auch deren weitere Nutzung zusätzliche Schwierigkeiten mit sich. Auf die Daten muss zum Beispiel hinreichend schnell zugegriffen werden können und die eingesetzte Software muss speziell auf den Umgang mit großen Datenmengen zugeschnitten sein.

Datenaggregierung

Einer Vielzahl dieser Herausforderungen kann mit einer sogenannten Aggregierung von Daten begegnet werden. Hierbei wird idealerweise zum Zeitpunkt der Datenerhebung in Echtzeit aus den Rohdaten ein Daten-Kondensat mit reduziertem Speicherbedarf erzeugt, das dennoch wesentliche Informationen des Ursprungssignals beibehält. Dieses Kondensat ermöglicht schnelle Einblicke in große Datensätze und dient als Wegweiser und Indikator bei der Analyse. Es sind verschiedene Möglichkeiten der Aggregierung geläufig. So kann etwa über die Zeit oder auch über Kanalgruppen aggregiert werden.

Zeitliche Aggregierung

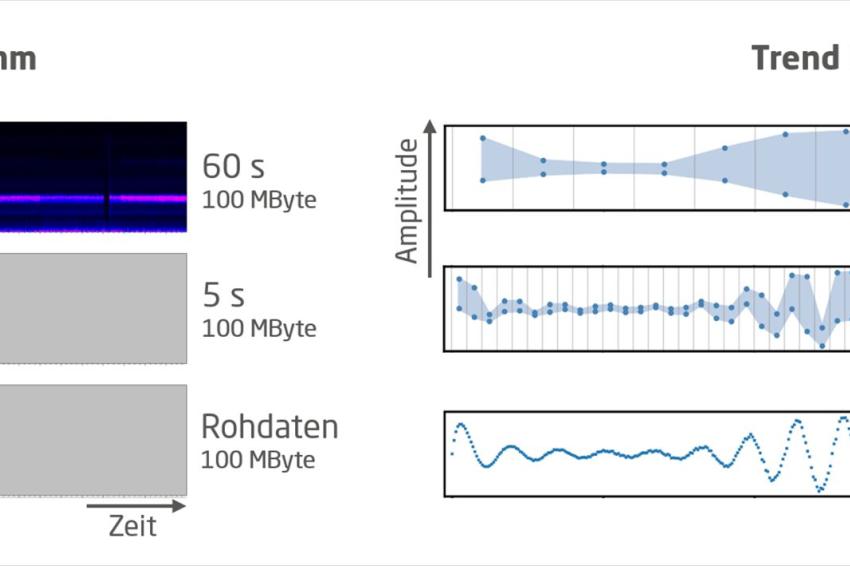

Ersteres ist in Abbildung 2 illustriert. Ein hochaufgelöstes Signal wird hier über aufeinander folgende Zeitfenster jeweils zu drei Datenpunkten aggregiert: Der erste Punkt entspricht dem minimalen Wert des Signals innerhalb des Zeitfensters, der zweite dem maximalen und der dritte dem durchschnittlichen Wert. Auf diese Weise werden drei neue Signale erzeugt, welche das Ausgangssignal charakterisieren und deren zeitliche Auflösung und damit Speicherbedarf von der gewählten Fensterbreite abhängen. Die zeitliche Aggregierung von Daten erlaubt es somit, große Zeitbereiche effizient zu analysieren. Abbildung 3 veranschaulicht diesen Vorteil. In der linken Bildhälfte sind Spektrogramme von 100 MByte an Sensordaten für zwei Aggregierungsstufen samt Rohdaten dargestellt. Während ohne Aggregierung lediglich ein sehr kurzer Zeitabschnitt abgedeckt wird (unten), lässt sich in der höchsten Aggregierungsstufe (60 s) ein viel weiterer Bereich überblicken. Wird hier eine Auffälligkeit entdeckt, kann durch Laden der nächstfeineren Aggregierungsstufe (5 s oder Rohdaten) gezielt in die Daten hineingezoomt werden. In der rechten Bildhälfte ist dies analog für den Zeitbereich illustriert. Die zu verarbeitenden Daten werden auf diese Weise minimiert, was speicher- und recheneffizient ist und damit für große Datensätze effektives Arbeiten überhaupt erst ermöglicht.

Aggregierung über Kanalgruppen

Neben der zeitlichen Aggregierung stellt auch die Aggregierung über eine Gruppe an Signalen ein wichtiges Werkzeug dar. Auf diese Weise lassen sich etwa die verschiedenen Brennkammern einer Gasturbine oder die einzelnen Zylinder eines Motors effizient überwachen. Das Prinzip ist in Abbildung 4 veranschaulicht. Von einer definierten Gruppe an Signalen wird zu jedem Zeitpunkt nur der maximale Signalwert sowie dessen Ursprung gespeichert. Werden zum Beispiel die Temperaturen an den einzelnen Zylindern eines Motors überwacht, so kann im aggregierten Signal auf einem Blick gesehen werden, in welchem Zylinder derzeit die höchste Temperatur herrscht und wie hoch diese ist.

Datenaggregation ermöglicht kosteneffizienten Maschinenbetrieb

Daten können auf verschiedene Art und Weise zu einem Daten-Kondensat aggregiert werden, wobei die verschiedenen Formen der Aggregierung problemlos kombiniert werden können. Dies führt dazu, dass weniger Signale und Datenpunkte verarbeitet werden müssen, was den Datenumfang reduziert und somit den Fokus auf das Wesentliche erhöht. Damit steigt die Wahrscheinlichkeit, auffällige Messwerte und Trends zu bemerken und rechtzeitig eine gezielte Wartung der Maschine durchführen zu können – mit erheblich niedrigeren Kosten.

Kontakt

IfTA GmbH

Junkersstraße 8

82178 Puchheim

+49 8392 719 84

+49 8392 719 11