Virtuelle Welten in Echtzeit erleben

Stellen Sie sich vor, Sie könnten das in Libyen gelegene Leptis Magna, größte heute noch erhaltenen Stadt des antiken römischen Reiches, bequem von Ihrem Wohnzimmersessel aus besuchen. Oder aber Sie würden einen Gebäudekomplex durchschreiten, lange bevor dieser gebaut wird. Zwei typische Gedankenspiele, die zu einer stetig wachsenden Anzahl inzwischen handelsüblicher Produkte für erweiterte und virtuelle Realität (ER und VR) führen. Für ER- und VR-Anwendungen ist dabei die Echtzeitverarbeitung der Bewegungen von Menschen oder Objekten im Raum zur exakten Positions- und Bewegungsbestimmung innerhalb eines definierten Koordinatensystems mittels optischer Messtechnik eine Grundvoraussetzung.

Wenngleich es auch in den letzten 10 Jahren einen dramatischen Preisverfall für Rechenleistung, Projektion und Darstellung gab, bleiben die Kosten für bewegungsbestimmende Komponenten weiterhin auf hohem Niveau. Darum hat ein Forschungsteam der Interactive Media Systems Group der TU Wien damit begonnen, ein eigenes, einfach zu bedienendes low-cost Motion-Tracking System zu entwickeln. Hiermit können immersive VR-Anwendungen kostengünstiger realisiert und damit einem breiteren Publikum zugänglich gemacht werden. 2007 startete das Wiener Team das Projekt „iotracker" (www.iotracker.com). Dieses Projekt hat die Entwicklung kostengünstiger optischer Infrarot-Tracker zum Ziel, die den strengen Anforderungen für Bewegungsbestimmung in den für immersive Visualisierungssysteme benötigten sechs Freiheitsgraden gerecht werden.

Spaziergang durch die virtuelle Welt

Optischen Motion-Tracking-Systemen verwenden in der Regel mehrere, zweidimensionale Bildsensoren (Kameras), die die Eingabeobjekte erkennen, die entweder mit „aktiven" (infrarot-emittierenden) oder „passiven" (retroreflektierenden) Markierungen ausgestattet sind. Das iotracker-System besteht aus bis zu acht kleinen, kalibrierten Infrarotkameras mit integriertem IR-Stroboskop, einer Synchronisierungseinheit, einem PC mit der iotracker Software sowie mehreren Starrkörpermarkern, die an den unterschiedlichen Eingabeobjekten befestigt sind. Durch die Daten, die diese Kameras sammeln, kann das System die genaue Lage jedes einzelnen Markers durch Triangulation berechnen. Sind mehrere Marker zu einem Starrkörperobjekt gruppiert, kann nun auch dessen Ausrichtung in bis zu sechs Freiheitsgraden (6-DOF, degrees of freedom) bestimmt werden. So kann ein Anwender dann beispielsweise durch eine virtuelle Welt „spazieren" oder die Bewegung eines Objektes nach links, rechts, vor, zurück sowie nach oben oder unten erfasst werden.

Kalibrierung in drei Schritten

Die Kameras sowie die Ziele des iotracker-Systems müssen zunächst jedoch drei unterschiedliche Kalibrierungsschritte durchlaufen, um zuverlässige Triangulationen zu erzielen. Der erste Schritt ist die Messung der intrinsischen Parameter zur Kompensation von etwaigen optischen Fehlern des Systems. Diese können beispielsweise durch kleinste Abweichungen in der Kameraoptik hervorgerufen werden. Die Feststellung der intrinsischen Parameter wird noch durch iotracker selbst vor Auslieferung des Systems vorgenommen. Der zweite Schritt umfasst die extrinsische Kalibrierung, die durch den Anwender direkt am Einsatzort vorgenommen wird. Hierbei werden die genaue Lage und Position aller Kameras innerhalb des Systems bestimmt. Diese Kalibrierung muss bei jeder Positionsänderung einer Kamera erneut vorgenommen werden, dauert jedoch nur wenige Minuten. Der letzte Kalibrierungsschritt dient der Erkennung der Starrkörpermarker innerhalb des Systems. Nach abgeschlossener Kalibrierung ist das iotracker-System dann in der Lage, innerhalb des gesamten Erfassungsraumes Punktmessungen mit Sub-Millimeter-Präzision sowie einem Effektivwert von unter 5 mm vorzunehmen.

Kostengünstige und präzise Kameras

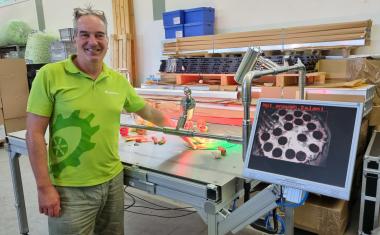

Iotracker setzt zur Bilderfassung auf das Digitalkameramodul Firefly MV IEEE 1394a von Point Grey Research. Die kompakten Firefly MV Kameras verfügen über eine eigene Kontrolleinheit, die in einem nur 71 x 66 x 40 mm großen Spezialgehäuse in direkter on-board Montage untergebracht ist. Weiterhin sind in diesem Gehäuse die Kamera selbst sowie eine IR-LED-Matrix integriert. Die M12 Mikrolinse mit einer Brennweite von 3,6 mm kann zusammen mit dem Weitwinkel-IR-Emitter ein diagonales Sichtfeld von bis zu 90° erfassen. So ist es möglich, ein maximales Raumvolumen von bis zu 40 m3 zu vermessen. Die Firefly MV basiert auf einem 1/3-Zoll Wide-VGA Monochrom-CMOS-Sensor mit globalem Shutter. Der CMOS selbst stammt von Micron (www.micron.com) und arbeitet bis in den nahen (850 nm) Infrarotbereich. Hierdurch können schnellere Verschlusszeiten erzielt und Bewegungsunschärfen, typisches Problem bei Hochgeschwindigkeits-Kamerasystemen, deutlich reduziert werden.

„Point Grey ist in der Wissenschaftsgemeinde als kostengünstiger Lieferant von Produkten zur industriellen Bildverarbeitung und Stereoskopie bekannt. An der TU Wien arbeiten wir viel mit Point Grey Produkten", so Thomas Pintaric, Chefentwickler bei iotracker. „Für die Firefly MV haben wir uns aus einer ganzen Reihe von Gründen entschieden. Sie ist die kostengünstigste Kamera die den IIDC v1.31-Standard erfüllt. Anders als preislich ähnliche IIDC v1.04-Kameras verfügt die Firefly MV jedoch auch über einen externen Auslösemechanismus, den wir für die präzise Synchronisierung der Shutter mehrerer Kameras nutzen."

Positionsbestimmung in hoher Geschwindigkeit

Das iotracker-System setzt auf passive Starrkörpermarkierungen aus retroreflektiven, sphärischen Objekten. Das Design der Ziele wurde computergestützt auf maximale Erfassungsleistung und minimale Selbstverdeckung optimiert. Sie werden aus leichten Kohlefaser- und Polyamidwerkstoffen hergestellt und mit einer retroreflexiven Beschichtung von Industriequalität (EN 471 Class 2) versehen. Die Spezialbeschichtung reflektiert den Großteil des emittierten Infrarotlichtes direkt zurück auf den Bildsensor der iotracker-Kamera. Die Kameras können dabei sowohl an der Wand als auch auf Stativen montiert werden. Synchronisiert werden sie per BNC-Koaxialkabel über ein Auslösesignal, dass die Synchronisierungseinheit des iotracker-Systems generiert. Jede Kameraeinheit sendet ihre digitalen Videodaten mit einer Bildfrequenz von 60 Einzelbildern pro Sekunde über eine IEEE-1394a-Verbindung (400 Mbit/s FireWire) an die Erfassungs-Workstation. „Dadurch, dass wir zwei Firefly-MV-Kameras über nur einen IEEE-1394a-Bus bei voller Bildwiederholrate und einer Auflösung von 608 x 480 Pixeln betreiben können, konnten wir das Design des Systems erheblich vereinfachen", erläutert Pintaric, „denn so können wir erheblich mehr Kameras pro Workstation betreiben".

Die Kameras übertragen kontinuierlich Bilder an die Workstation. Dort verarbeiten die fortschrittlichen Bildverarbeitungs-Algorithmen der iotracker-Software in Echtzeit das jeweilige Zentrum der einzelnen Marker. Die 3D-Positionsbestimmung der Marker wird dann durch Triangulation bestimmt. Die Software identifiziert dabei die vorkalibrierten Starrkörpermarker und ermittelt deren Position und Ausrichtung. Danach werden die erhaltenen 6-DOF-Daten über eine TCP/IP Ethernet-Verbindung an angeschlossene Clients übermittelt. Durch die hohe Bildwiederholrate der Kameras und die Geschwindigkeit der iotracker-Software ergeben sich dabei sehr niedrige Latenzen von, je nach Anzahl der sich im System befindenden Starrkörpermarker, 18-40 ms. Durch einen eigenen Virtual Reality Peripheral Network Server (VRPN-Server) wird eine Vielzahl an Drittanwendungen unterstützt. So können beliebige VRPN-Clients die Tracking-Daten des Systems standardisiert über TCP/IP nutzen.

„Das modulare Design von iotracker erlaubt eine Konfiguration des Tracking-Systems ganz nach den jeweiligen spezifischen Bedürfnissen des Anwenders", erklärt Dr. Zsolt Szalavari, Produktmanager beim iotracker-Distributor Imagination Computer Services. „Die hohe Genauigkeit, das große Erfassungsvolumen sowie die einfache und flexible Handhabung ermöglichen vielfältige Anwendungen unter anderem in der VR/ER-Forschung, für Walk-Throughs in der Architektur, für die Entscheidungsfindung im Ingenieurwesen und Maschinenbau oder aber auch für die generelle Bewegungserfassung in Echtzeit. Es ist auch das erste optische Motion-Tracking-System, das alle Vorteile der hochpräzisen Bewegungserfassung bei kleinstmöglichem finanziellen Einsatz ermöglicht."

Point Grey Research Inc., www.ptgrey.com

Interactive Media Systems Group, Vienna University of Technology, www.ims.tuwien.ac.at

Imagination Computer Services GesmbH, www.imagination.at