Terahertz-Lichtfeld-Bildgebung mit voll integrierten CMOS-Modulen

28.06.2023 - Entwicklung einer modularen THz-LF-Kamera

Die Lichtfeld-Bildgebung (LF) ist eine äußerst vielseitige Rechentechnik für die 3D-Szenenrekonstruktion, Tiefenabschätzung und Bearbeitung von Inhalten. Die Kombination von LF mit Terahertz-Detektoren für Echtzeit-Durchsichtsaufnahmen wird zu neuen Anwendungen in den Bereichen Sicherheit, Medizin und Industrie führen.

Der Terahertz-Frequenzbereich (Wellenlänge), der zwischen 300 GHz (1 mm) und 3 GHz (0,1 mm) liegt, bietet einzigartige Vorteile für Bildgebungs- und Erfassungsanwendungen. Im Vergleich zu den niedrigeren Frequenzen der Mikrowellen oder Millimeterwellen (mm-Wellen) bieten Terahertz-Wellen eine feinere Bildauflösung im Sub-mm-Bereich, die mit der des menschlichen Auges vergleichbar ist und ausreicht, um die Formen der meisten alltäglichen Objekte aufzulösen. Terahertz-Wellen werden von Wassermolekülen stark absorbiert, von Metallen reflektiert und sind für dielektrische Materialien wie Kunststoffe des täglichen Gebrauchs durchlässig, ähnlich wie Röntgenstrahlen. Diese besitzen jedoch Photonen mit hoher Energie, die zu einer Ionisierung von Biomolekülen wie den menschlichen Genstrukturen führen können, weshalb die Röntgendosis begrenzt und abgeschirmt werden muss, um eine unbeabsichtigte Exposition zu verhindern. Im Vergleich dazu haben THz-Wellen keine derartigen Nebenwirkungen, und sie können frei eingesetzt werden.

Daher hat die THz-Bildgebung ein großes Potenzial für Sicherheitskontrollen, Verpackungsinspektion, Qualitätskontrolle, biomedizinische Diagnose und Kunsterhaltung. Bis vor kurzem konzentrierte sich die Aufmerksamkeit auf die herkömmliche 2D-Bildgebung aufgrund der Einschränkungen der THz-Hardwarekomponenten. Die modernsten THz-Sender und -Empfänger sind entweder leistungsschwach oder nicht ausreichend integrierbar, um in anspruchsvolle rechnergestützte Bildgebungsverfahren wie die Lichtfeld-Bildgebung integriert zu werden.

Die Lichtfeldabbildung (LF) ist eine robuste Rechentechnik, die auf der Ray-Tracing-Geometrie für die 3D-Szenenrekonstruktion, Tiefenabschätzung und Inhaltsbearbeitung basiert. Dabei wird das in das Objekt ein- und ausströmende Licht als ein aus Strahlenbündeln zusammengesetztes Vektorfeld betrachtet, das anhand der Energiedichte entlang einer bestimmten Richtung und Position im 3D-Raum quantifiziert wird. Wenn die Position und die Flussrichtung der einzelnen Lichtstrahlen bekannt sind, kann entweder die Rückwärtsausbreitung (vom Sensor) oder die Vorwärtsausbreitung (von der Quelle) angewendet werden, um eine 3D-Volumenquelle der Feldstörung zu rekonstruieren. Die Lichtfeldmethode funktioniert mit inkohärenter Strahlung, erfordert jedoch räumlich ausgerichtete Quellen und Detektoren, d. h. Komponenten, die das Licht entlang mehrerer Winkel an verschiedenen Orten im Raum synthetwisieren und erfassen können. Isotrope, inkohärente Quellen eignen sich hervorragend zur Erzeugung räumlich gerichteter Lichtfelder, die von einer Kamera leicht abgetastet werden können. Lichtfeldtechniken sind für die Bildgebung mit sichtbarem Licht sehr populär geworden, da solche Quellen und preiswerte Kameras allgegenwärtig sind.

Wie funktioniert die Lichtfeldabbildung?

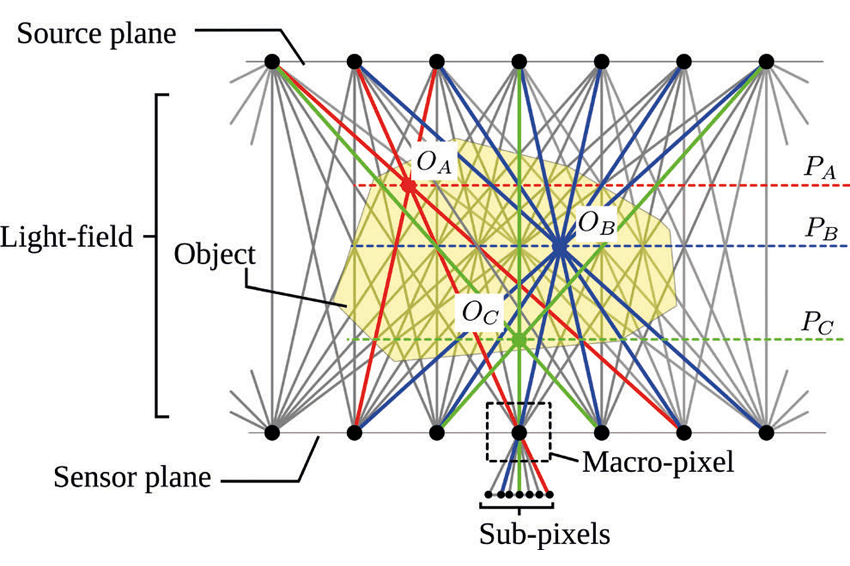

Die Grundidee der Lichtfeldabbildung besteht darin, den Raum zwischen zwei Ebenen abzubilden, von denen die eine als Quellenebene und die andere als Sensorebene auf der Grundlage der Richtung des Energieflusses als Vektorfelder klassifiziert wird. Eine solche Darstellung kann einen Unterraum eines vollständigen Lichtfeldsystems umfassen, das auch aus anderen Komponenten wie Linsen und Spiegeln bestehen kann. Es wird angenommen, dass die Quellen und Sensoren isotrop sind, d. h. sie strahlen Energie in alle Richtungen ab beziehungsweise nehmen Energie in alle Richtungen auf. Unter der Annahme, dass es keine Welleneffekte (Beugung und Interferenz) gibt, bilden die geraden Linien zwischen den Quellen und den Sensoren die Lichtstrahlen. Ein Objekt, das sich zwischen den beiden Ebenen befindet, wird teilweise durchgelassen und teilweise reflektiert, wodurch das Lichtfeld gestört wird. Wenn alle räumlich gerichteten Lichtstrahlen auf der Sensorebene abgetastet werden können, kann die Strahlenverfolgung und die Integration der Lichtintensität entlang verschiedener Strahlensätze in der Nachbearbeitung die Fokussierung auf verschiedene Teile des Objekts (einschließlich seiner Tiefenachse) ermöglichen. Das Konzept kann auf mehrere Strahlensätze erweitert werden, um drei 2D-Bilder zu erfassen, die verschiedenen Ebenen in der Szene entsprechen und Querschnitte entlang der Objekttiefe bilden, was zu einer 3D-Rekonstruktion führt.

Wie wird das Lichtfeld abgetastet?

Wenn jeder Punkt auf der Sensorebene ein einzelnes Pixel ist, werden alle Lichtstrahlen, die innerhalb dieses Pixels erfasst werden, in ihrer Intensität integriert, und die räumlich-gerichtete Information geht unwiderruflich verloren. Stattdessen sind an jeder Sensorposition mehrere Unterpixel erforderlich (Makropixel), um das einfallende Licht in verschiedenen Richtungen abzutasten. Dieses Makro-Pixel ist der wichtigste Baustein für jedes Lichtfeld-Bildgebungssystem. Die Objektabtastdichte entspricht der Diskretisierung des Lichtfeldes, die mit der räumlichen und winkelmäßigen Anordnung der Sub- und Makropixel zusammenhängt.

Lichtfeldabbildung bei sichtbaren und Terahertz-Wellenlängen

Die ersten Demonstrationen basierten auf der Abtastung einer Szene durch die Bewegung einer einzelnen Kamera für Anwendungen wie die Modellierung einer 3D-Beleuchtungsquelle, die virtuelle Bilddarstellung, die digitale Archivierung von Skulpturen der Renaissancekunst und interaktive Stadtpanoramen. Es wurden kompakte Lichtfeldkameradesigns demonstriert, die aus einem 2D-Array von Mikrolinsen bestehen, die über einem digitalen Kamerasensor angeordnet sind. Diese Technologie wird nun für die 3D-Bildgebung und die computergestützte Apertursynthese in der Fotografie und 3D-Mikroskopie vermarktet. Einige dieser Fortschritte haben zu den Multikamera-Konfigurationen geführt, die in modernen Smartphones weit verbreitet sind.

Es gibt viele Ähnlichkeiten zwischen dem sichtbaren Licht und den inkohärenten THz-Lichtfeldsystemen. Beide erfordern räumlich ausgerichtete Sensoren und eine diffuse Beleuchtung. Die plenoptische Funktion ist bei beiden ganzzahlig, und die Intensität nimmt bei einer sphärischen Wellenfront im Fernfeld für eine Entfernung r von einer Punktquelle um 1/r² ab. Es gibt jedoch auch signifikante Unterschiede zwischen THz und sichtbarem Licht, die einzigartige Herausforderungen für THz-Lichtfeldsysteme darstellen.

Erstens ist die Wellenlänge im THz-Bereich fast drei Größenordnungen größer als die des sichtbaren Lichts. Dies schränkt die dichte Anordnung der Sensorpixel aufgrund der größeren Beugungsgrenzen stark ein. Außerdem gibt es bisher keine isotropen inkohärenten THz-Quellen mit hoher Intensität. Ohne eine geeignete Beleuchtung ist es nicht möglich, eine rechnerische Lichtfeldabbildung durchzuführen. Das Gleiche gilt auch für THz-Sensoren. Eine weitere, besonders wichtige Herausforderung bei THz ist die geringe Integrationsdichte, da nur einige Hundert THz-Sensoren in ein Focal-Plane-Array (FPA) integriert werden können, verglichen mit Sensoren für sichtbares Licht mit Millionen von Pixeln. Dies schränkt die Lichtfelddichte und die erreichbare Bildauflösung unmittelbar ein. Die Linsenarrays, die für die Erfassung des räumlich-gerichteten Lichtfelds in Kompaktkameras erforderlich sind, sind bei THz-Frequenzen ebenfalls nicht verfügbar.

Erfassen der räumlich-direktionalen Lichtfeldvielfalt in einem Multi-Chip-Terahertz-Kamera-SoC?

Die erste Voraussetzung für die LF-Bildgebung sind große Focal-Plane-Arrays (FPA) von Detektoren, die in der Lage sind, verschiedene Lichtfelder in verschiedenen Raumrichtungen aufzulösen. Könnte eine voll integrierte THz-Digitalkamera, die aus 2D-Arrays von antennengekoppelten CMOS-Direktdetektoren besteht, die mit einer hyper-hemisphärischen Siliziumlinse mit hohem Widerstand gekoppelt sind, zur Erfassung von räumlich-gerichteten Lichtfeldern eingesetzt werden?

In der Konfiguration des in Siliziumlinsen integrierten THz-FPA strahlen die Antennen von der Rückseite (zum Substrat hin) des Chips ab. Die Ausdehnungslänge dieser Linse wird so gewählt, dass sich das Pixel-Array im Brennpunkt einer ungefähren Ellipse befindet, die von der hyper-hemisphärischen Linse gebildet wird. Dies ermöglicht eine Pixel-Winkel-Zuordnung, das heißt, dass die räumliche Position eines Pixels auf dem Array direkt mit den Empfangswinkeln übereinstimmt. Die Abbildung ist deterministisch und kann bis zur ersten Ordnung mit einem Lochkamera-Bildgebungsmodus vorhergesagt werden. Tatsächlich spielt die Siliziumlinse die Rolle eines Makropixels und die 2D-Arrays von Detektorpixeln die Rolle eines Subpixels, das Richtungsvielfalt bietet. Das Blockdiagramm eines voll integrierten THz-Lichtfeld-Subpixels besteht aus 32x32 antennengekoppelten CMOS-THz-Leistungsdetektoren. Diese Detektoren weisen breitbandige Spektraleigenschaften mit der besten Betriebsfrequenz bei 600 GHz und einer 3dB-Bandbreite von fast 300 GHz auf. Die Detektoren werden im Rolling-Shutter-Modus durch eine On-Chip-Logik zur Zeilen- und Spaltenauswahl aktiviert, und die programmierbaren Gate-Arrays, der Correlated Double Sampler (CDS) zur Offset-Unterdrückung und der ADC werden global von allen Detektoren gemeinsam genutzt.

Ein vollwertiges THz-Lichtfeldkamera-SoC wird durch die Implementierung großer Arrays

solcher Makropixel und das Routing der Steuerlogik auf einer gemeinsamen Hauptplatine realisiert. Ein solcher Multi-Chip-Skalierungsansatz ist ein bequemer Weg, um die Herstellungskosten unter Kontrolle zu halten und gleichzeitig die fortschrittliche Funktionalität voll integrierter THz-Digitalkameras beizubehalten. Der modulare Aufbau ermöglicht eine flexible Skalierung des THz-Lichtfeld-Bildgebungssystems, und einzelne CMOS-THz-Digitalkameras können bequem ausgetauscht werden.

Ein Beispiel für die 3D-Rekonstruktion

Die THz-Lichtfeldkamera wurde für eine Echtzeit-Demonstration der Bildgebung verwendet. Die Kamera wurde vor einer 650-GHz-CW-AMC-Quelle platziert, und die Lichtfeld-Bilddaten wurden in Form eines Videos mit einer Gesamtbildrate von 4 fps gestreamt, wobei jede Teilkamera mit 36 fps gestreamt wurde. Die Bildaufnahmegeschwindigkeit war durch die kontrollierte Implementierung begrenzt - einzelne Befehle wurden nacheinander von einer Python-Schnittstelle gesendet, um die Datenerfassung von jeder Kamera auszulösen. Zu reinen Demonstrationszwecken wurde das 3x3-Array der THz-Lichtfeldkamera in 2D gestaffelt, um die Lichtfelder einer divergierenden Quelle zu erfassen. Die gesammelten räumlich-gerichteten Daten werden dann rechnerisch verarbeitet, um das Strahlungsmuster der AMC-Quelle zu rekonstruieren.

Literatur

[1] R. Jain et al., “A 32× 32 pixel 0.46-to-0.75 THz light-field camera SoC in 0.13 μ m CMOS,” 2021 IEEE ISSCC 64, 484-486.

[2] M. Levoy, “Light Fields and Computational Imaging,” Computer, vol. 39, no. 8, pp. 46-5, Aug. 2006.

[3] R. Ng et al., “Light Field Photography with a Hand-Held Plenoptic Camera,” Stanford

University Computer Science Tech Report (CSTR 2005-02), Stanford University, 2005.

[4] R. Jain et al., “Terahertz Light-Field Imaging,” IEEE Trans. Terahertz Science and Technology, vol. 6,

no. 5, pp. 649-657, Sept. 2016.

Kontakt

Bergische Universität Wuppertal

Gaußstraße 20

42119 Wuppertal

+49 202 439 0