Die Mächtigkeit von Sprachmodellen

Anwendungsmöglichkeiten für Service- und Industrieroboter

Ein Kommentar von Oliver Bendel, Dozent an der Fachhochschule Nordwestschweiz mit Forschungsschwerpunkt Informations-, Roboter- und Maschinenethik

Im Jahre 2019 schrieb ich für meinen Herstellerband Maschinenliebe führende Experten auf diesem Gebiet an. Ein US-Amerikaner, den ich bei einem Workshop an der Universität Potsdam kennengelernt hatte, sagte zu. In seinem Beitrag Speaking with Harmony thematisierte er, wie GPT-2 für die natürlichsprachlichen Fähigkeiten des aus dem Film Hi, AI bekannten sozialen Roboters verwendet werden kann. Ich erinnere mich gut, dass er mich schon in Potsdam auf die Mächtigkeit solcher Sprachmodelle hingewiesen hatte.

Ein Large Language Model (LLM) ist ein Sprachmodell, das aus einem neuronalen Netzwerk mit vielen Parametern gebildet wird. Man füttert es mit großen Mengen an unmarkiertem Text, etwa aus Büchern, Artikeln und Blogs. Trainiert wird es durch selbstüberwachtes oder halbüberwachtes Lernen. LLM können die Wahrscheinlichkeit dafür angeben, welches Wort auf ein Wort in einem Satz folgt und welcher Satz auf einen Satz in einem Absatz. In der Umsetzung entsteht ein oftmals überzeugender Text in natürlicher Sprache.

Sprachmodelle dieser Art umfassen einen Großteil der Syntax und Semantik zahlreicher menschlicher Sprachen. Wichtig ist, dass es sich um digitale Texte handelt. Natürlich können Tonaufnahmen verschriftlicht werden – dies verlangt einfach einen zusätzlichen Arbeitsschritt. Zugleich verfügen LLM über ein profundes Allgemeinwissen, wenn man von Wissen sprechen will, und mit dem entsprechenden Training kann man sie auf Fachgebiete spezialisieren.

GPT-3 und GPT-4 von OpenAI sind bekannte Beispiele für ein LLM. GPT steht für Generative Pretrained Transformer. Unser Chatbot @ve, den wir 2022 gebaut haben, basiert auf GPT-3. Man kann sich auf Latein mit ihm unterhalten, also in einer toten Sprache, die nun ziemlich lebendig erscheint. Der Chatbot beziehungsweise Textgenerator ChatGPT und der Bildgenerator DALL-E, beide von OpenAI, greifen ebenfalls auf Versionen von GPT-3 zurück. Andere Sprachmodelle sind LaMDA von Google AI (Grundlage für Bard), LLaMA von Meta und PaLM-E von Google und TU Berlin. Man spricht insgesamt von generativer KI (engl. generative AI).

Mit Sprachmodellen Roboter sprechen lassen und steuern

Die Trainingsdaten von ChatGPT stammen unter anderem aus Foren, Artikeln und Büchern sowie von gesprochener Sprache. Benutzt wird eine spezielle Form von Machine Learning, nämlich Reinforcement Learning from Human Feedback (RLHF). Der Mensch ist im Loop und beeinflusst das System. Mit ChatGPT hat OpenAI einen Coup gelandet. Ein sehr leistungsfähiges System wurde für die Weltöffentlichkeit freigegeben. Und diese hatte den Eindruck, zum ersten Mal künstliche Intelligenz ausprobieren zu können. Selbst wenn viele bereits DeepL und weitere KI-Tools kannten.

Die Mächtigkeit, auf die mein Kollege hingewiesen hatte, bezieht sich aber nicht nur auf die virtuelle Welt allein, und nicht nur auf die virtuelle Welt in der realen, wie es bei Chatbots und Sprachassistenten der Fall ist, die man in Geräte einpflanzt. Man kann mit Sprachmodellen regelrecht virtuelle und reale Welt verbinden. Man kann Roboter nicht nur sprechen lassen, sondern auch steuern. Es ist erstaunlich, dass dies in den Medien und in der Öffentlichkeit kaum Erwähnung findet. Es mag mit dem Begriff des Sprachmodells selbst zu tun haben.

PaLM-E ist für Serviceroboter nutzbar, wie auch ChatGPT for Robotics – so lautet der Titel eines einschlägigen Papers von Microsoft. Über die Roboterkameras erfasste Bilder von Räumen und Objekten und ihren jeweiligen Zuständen im Zeitverlauf werden in das Sprachmodell integriert. Der Serviceroboter – hier ein Cobot auf einer mobilen Plattform – kann auf Zuruf beliebige Aufgaben erledigen, ohne dass er diese vorher kennen und bewältigen muss – zum Beispiel Hole mir die Reischips aus der Schublade!

Es werden also soziale Roboter und Serviceroboter auftauchen, die sich in einer beliebigen, bis dahin unbekannten Umwelt bewegen und in dieser dazulernen. Der Benutzer formuliert einfach einen Prompt – nichts anderes ist der erwähnte Zuruf, der genauso eine Texteingabe auf dem Display sein könnte – und lässt diesen von dem Roboter abarbeiten. Profitieren werden nicht nur spezialisierte Modelle wie Pflegeroboter, sondern auch universelle Modelle, wie sie Elon Musk mit seinem Optimus vorschweben.

Es handelt sich übrigens um Multimodalität im mehrfachen Sinne. In das Sprachmodell, das auf Sprache aufsetzt, werden Bilder aufgenommen. Der Input, der Prompt, kann über geschriebene oder gesprochene Sprache erfolgen – oder über Bilder. Der Output liegt in Form von Aktivitäten vor, von Körper-, Arm- und Handbewegungen. Und, wenn man will, in Form gesprochener Sprache. So könnte der Roboter am Ende ausrufen: Hier sind die Reischips! Damit würde er anzeigen, dass die Aufgabe abgearbeitet ist.

Roboter profitieren vom Allgemeinwissen der Sprachmodelle

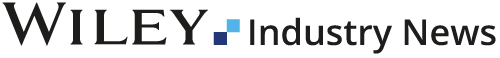

Auch die moderne Industrierobotik könnte gewinnen. In dieser Richtung engagiert sich die Firma Aleph Alpha aus Heidelberg mit ihrem Sprachmodell namens Luminous. Mit ihm kann man einen Cobot ausstatten und betreiben, wie auf der Hannover Messe 2023 demonstriert wurde. Im Video sieht man einen zweiarmigen Roboter, dahinter die Zeile Generative AI in Manufacturing. Man kann mit ihm sprechen und ihm Befehle erteilen – und er kann diese verstehen und ausführen.

Man könnte es so formulieren, dass Roboter nun vom Allgemeinwissen der Sprachmodelle profitieren. Und von ihrer Wahrnehmungsfähigkeit, die damit zusammenhängt, dass nicht nur Texte erfasst und verarbeitet werden, sondern ebenso Bilder und andere Erzeugnisse der Sensoren. Auch Töne und Gerüche mag man mit der Zeit in PaLM-E, Luminous und Co. aufnehmen und so die Endergebnisse weiter verbessern und die Einsatzgebiete weiter vergrößern und vermehren.

Ein Paper der University of Texas, das bei Nature Neuroscience am 1. Mai 2023 veröffentlicht wurde, stellt ein vielleicht wegweisendes Experiment dar. Die Probanden lagen zuerst einige Stunden in einem Magnetresonanztomografen und hörten gesprochene Erzählungen in Form von Podcasts. Die Forscher zeichneten auf, wie Wörter und Sätze bestimmte Aktivitäten in den entsprechenden Hirnregionen auslösten. Mit diesen Daten wurde ein Sprachmodell trainiert. Dann wurden den Probanden neue Geschichten vorgespielt, während man wieder die Hirnaktivitäten aufzeichnete. Das auf dem Sprachmodell basierende System gab die wahrscheinlichsten Phrasen an. Tatsächlich waren Überschneidungen mit dem neuen Material vorhanden. Die Medien feierten die Studie als Erfolg auf dem Weg zum Gedankenlesen. Als Ethiker musste ich im Fernsehstudio antreten und auf die Risiken hinweisen. Viel lieber hätte ich etwas zu den Chancen gesagt.

Wenn es gelingen würde, mit Hilfe von Sprachmodellen Gedanken zu lesen, könnte ein Querschnittsgelähmter oder ein Schlaganfallpatient, der nicht mehr sprechen kann, einen Serviceroboter anweisen, etwas für ihn zu tun. Dieser könnte einen Behälter für ihn holen und ihm Flüssigkeit zuführen. Er könnte die Person in Zukunft sogar waschen und umziehen. Daran wird gerade geforscht, unter Einbezug Künstlicher Intelligenz. Mit Hilfe von Sprachmodellen könnte alles schneller in der Praxis sein als gedacht.

Generative AI in Manufacturing

Auch für Industrieroboter brechen neue Zeiten an. Weniger für die alten, die in Käfigen oder in Sperrgebieten untergebracht sind, damit sie uns nicht verletzen. Eher für die neuen, die eng mit uns zusammenarbeiten, wobei jeder seine Stärken ausspielt. Es sind die Cobots, die von Sprachmodellen profitieren können, in Bezug auf ihre Kooperation, das gemeinsame Ziel, und in Bezug auf die Kollaboration, die gemeinsame Aufgabe, die Hand in Hand mit Menschen angegangen wird. Vielleicht wird Generative AI in Manufacturing die Schlagzeile dazu sein.

Im Frühjahr 2023 war ich mit dem Kollegen aus den USA erneut in Kontakt. Er betonte die Mächtigkeit von Sprachmodellen, aber auch ihre Beschränkung in manchen Aspekten. Es geht in seinem Unternehmen nach wie vor darum, Harmony natürlichsprachliche Fähigkeiten beizubringen. Er sprach in diesem Zusammenhang von Neo-Victorian corporate conservatism. Übersetzt heißt das: GPT ist einfach zu prüde.