Algorithmus spart Bandbreite ohne Qualitätsverlust

Bilddatenkomprimierung bedeutet nicht mehr Einbußungen in puncto Qualität.

Durch die begrenzte Bandbreite und Rechenkapazität in Embedded-Vision-Anwendungen wird die Kompression der Bilddaten zum Schlüssel des Erfolgs in anspruchsvollen Bildverarbeitungsanwendungen. Aber wie kann der Datenfluss reduziert werden, ohne dass die Bildqualität und somit die Bildverarbeitungsqualität darunter leidet? Ein israelisches Unternehmen kennt die Antwort.

Vor nicht allzu langer Zeit basierten die meisten Bildverarbeitungssysteme auf Kameras mit Auflösungen unter einem Megapixel. 5 Megapixel galt schon als relative hohe Auflösung in der Machine-Vision-Welt. Heute sind Sensoren mit 12, 16, 20 oder 25 Megapixel wie die IMX54x-Modelle von Sony keine Besonderheit mehr und der Markt bietet Kameras über 100 Megapixel für besonders anspruchsvolle Anwendungen.

Höhere Auflösungen und Framerates erfordern Schnittstellen mit höherer Bandbreite. So wundert es nicht, dass die Beliebtheit von breitbandigen Kamera-Interfaces in den letzten Jahren ebenfalls gestiegen ist: USB3 Vision, 5GigE, 10GigE, CoaXPress oder Camera Link verfügen über die notwendige Bandbreite für hohe Anforderungen.

Folglich müssen nun der Host-Prozessor und die Bildverarbeitungssoftware höhere Datenmengen verarbeiten können. Diese Herausforderung spitzt sich in neuen Systemkonfigurationen zu: Traditionelle Bildverarbeitungssysteme waren in industriellen Maschinen eingebaut mit einem leistungsstarken PC als Host, der die Bilddaten lokal verarbeitete. Heute kommt Vision zunehmend in mobilen Applikationen im Außenbereich, auf Embedded-Plattformen und mit einer Internetverbindung zur Cloud zum Einsatz. Selbst wenn die höhere Datenmenge von modernen Sensoren und Schnittstellen unterstützt wird – die Herausforderung verschiebt sich auf die Bildverarbeitung auf dem Host. Die Bilddaten müssen komprimiert werden.

Das Kompressionsdilemma: Bildqualität oder Kompression

Verlustfreie Kompressionsalgorithmen gibt es durchaus. Sie erhalten das Bild in seiner Originalqualität, dafür bleibt der Kompressionsfaktor bei etwa 2:1. Dies ist für hochauflösende, High-Speed-Bildverarbeitung unzureichend.

Kompressionsalgorithmen wie MPEG können die Bilddatenmenge um den Faktor 10 und mehr reduzieren. Dies erfolgt jedoch auf Kosten der Bildqualität. Für Verbraucher oder für manche industrielle beziehungsweise wissenschaftliche Anwendungen mag das akzeptabel sein. Zum Archivieren von Bilddaten ebenfalls. Für Bildverarbeitungsaufgaben mit hoher Präzision kann der Verlust an Bildqualität, vor allem an den Objektkanten, die Leistung und Zuverlässigkeit der Software gefährden.

Generische Algorithmen wie MPEG sind darauf ausgelegt, Filme im YUV-422- oder RGB-Format zu komprimieren. Deshalb reduzieren sie die Farbtiefe mit 420 beziehungsweise 422 Farbreduktion. Diese Algorithmen sind für hohe Auflösung optimiert und gehen davon aus, dass Hochfrequenzrauschen nicht nur akzeptabel, sondern gegebenenfalls sogar erwünscht ist, da es sich positiv auf die Schärfe auswirkt.

In vielen aktuellen Vision-Anwendungen wird jedoch in das Bild hineingezoomt und klare Kanten sind wichtig. In solchen Fällen ist das Hochfrequenzrauschen problematisch, und zwar umso mehr, wenn man gute Zoom-Algorithmen verwendet. Entwickler von hochauflösenden beziehungsweise High-Speed-Bildverarbeitungssystemen stehen deshalb vor einem Dilemma: entweder Bildqualität oder Kompression.

Warum nicht beides? Eine hohe Kompression bei guter Bildqualität

Gidel, ein israelisches Technologieunternehmen spezialisiert auf FPGA-Entwicklung für die Bildverarbeitung, hat eine lange Erfahrung im Bereich Bilddatenkompression. Vor über 25 Jahren hatte das Unternehmen bereits Gidel Imaging patentiert, ein Softwaretool zur Verbesserung der Bildqualität von JPEG-komprimierten Bildern durch Hochfrequenzrauschunterdrückung. Hierzu forschte das Unternehmen nach Algorithmen, die die korrekten DCT-Werte (Diskrete Cosinus Transformation) vor der Quantisierung der Bilddaten zurückermitteln konnten.

Heute präsentiert Gidel Quality+Compression, einen neuen Komprimierungsalgorithmus, der dieses Rauschen deutlich reduziert. Er bietet eine hohe Kompressionsrate und eine hohe Bildqualität zugleich. Über 1 Gigapixel pro Sekunde und Kamera lassen sich in Echtzeit auf einem FPGA mit geringem Stromverbrauch komprimieren. Somit eignet sich die Software besonders für Embedded-Systeme.

Maßgeschneiderte Kompression für jede Anwendung

Gidels Ansatz ist es nicht, wie in einer verlustfreien Kompression die Original-Bilddaten wiederherzustellen. Und im Unterschied zu gängigen Algorithmen wie MPEG wurde Gidel Quality+ Compression speziell für Bildverarbeitungsanwendungen mit einem fixen Blickwinkel entwickelt und optimiert.

Im ersten Schritt optimiert Gidel Quality+Compression die Kompression, ohne die Bildqualität zu reduzieren, indem Bilddaten eliminiert werden, die im Originalbild gar nicht erst erforderlich beziehungsweise erwünscht sind. Diese können Artefakte, Rauschen oder andere Bildeigenschaften sein, die nicht zu einer perfekten Bildqualität beitragen.

Des Weiteren unterscheidet sich Gidel Quality+Compression von generischen Algorithmen dadurch, dass sie personalisierbar ist. Die Software lässt sich mit realen Bildern aus der Applikation trainieren, um die Kompressionsparameter nach deren spezifischen Anforderungen zu optimieren. Somit liefert sie das bestmögliche Verhältnis zwischen Bildqualität und Datenmenge.

So erfordert zum Beispiel eine Überwachungsanwendung mit einer fixen Szene, in der Menschen oder Fahrzeuge vorbeiziehen, gegebenenfalls andere Kompressionseinstellungen als ein medizinisches Diagnosesystem oder eine industrielle Prüfanlage. Diese Anpassung der Komprimierungsparameter den spezifischen Anforderungen jeder Applikation ist der Schlüssel, um das Dilemma zwischen Kompression und Bildqualität zu brechen. Denn nur so lassen sich mehr Bildinformationen komprimieren, die für die jeweilige Anwendung irrelevant sind.

Bilderfassung und Kompression in einem Schritt

Der Algorithmus wurde entwickelt, um mehrere Kamera-Streams in Echtzeit zu komprimieren. Über 1 Gigapixel pro Sekunde und Kamera lassen sich verarbeiten. Die optimale Leistung wird mit Gidel Framegrabbers beziehungsweise Fantovision Embedded Computers erreicht. Systementwickler können aber auch ihr eigenes Gerät mit Gidels-FPGA-Modulen konstruieren.

Da der Algorithmus eine geringe Systemleistung und Stromversorgung bedarf, lässt sich die Kompression in einer frühen Phase des Bilderfassungsprozesses durchführen, noch vor dem Speichern oder Verarbeiten der Daten. Das entlastet GPU und CPU und vermeidet Engpässe zwischen Framegrabber und Host-Prozessor. Die Datenmenge, die verarbeitet, gespeichert oder in die Cloud hochgeladen wird, wird gleich an der Quelle reduziert. Quality+Compression verbraucht wenig FPGA-Rechenleistung, sodass Gidels Infinivision Software über zehn Kameras bei 1 Gigapixel pro Sekunde parallel und in Echtzeit erfassen und komprimieren kann. Dies ermöglicht kleine und leistungsstarke Bildverarbeitungssysteme mit geringem Gewicht und Stromverbrauch (SWaP).

Um die Anforderungen moderner Bildverarbeitungssysteme in puncto Auflösung und Bildrate zu erfüllen, sind intelligente Kompressionsalgorithmen gefragt, die einen hohen Kompressionsfaktor und eine hohe Bildqualität gewährleisten. Dafür muss erst einmal definiert werden, was Bildqualität ist. Jede Applikation hat ihre eigenen Anforderungen. Der optimale Kompromiss zwischen Kompression und Bildqualität lässt sich deshalb nicht mit einer Einheitliche Lösung erreichen, sondern nur mit personalisierten Algorithmen.

Autor

Reuven Weintraub

Gründer und CTO von Gidel

Anbieter

Gidel Ltd.2 Ha’ilan St. Northern Industrial Zone

30600 Or Akiva

Israel

Meist gelesen

Im Schlamm ruht sich ein großes Nilpferd aus

Virtuelle Video-Safaris für blinde und sehbehinderte Personen

Das Getriebe macht den Roboter

Kuka setzt bei größeren Roboterserien auf Zykloidgetriebe von Nabtesco

Robuste Zeichenerkennung mit Deep Learning

OCR-Anwendungen in industriellen Inspektionsprozessen

Effektives Recycling in industriellen Anlagen

Sortierung von schwarzem Kunststoff mit MWIR-Hyperspektralbildgebung

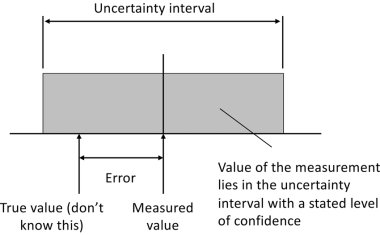

Messunsicherheit in der Fertigung: Grundlagen verstehen

Warum präzise Messergebnisse allein nicht ausreichen